物联网技术

DeepSeek新版模型正式发布,技术大佬们都转疯了!

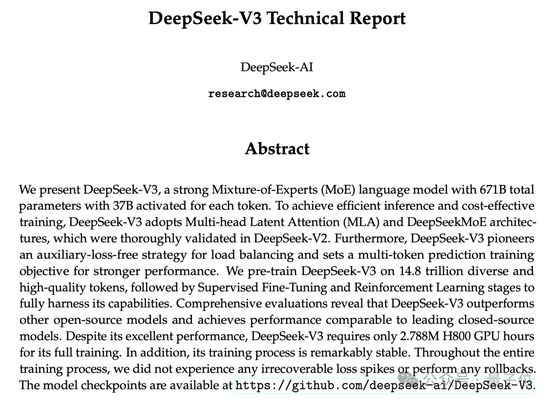

延续便宜大碗特点的基础之上,DeepSeek V3发布即完全开源,直接用了53页论文把训练细节和盘托出的那种。

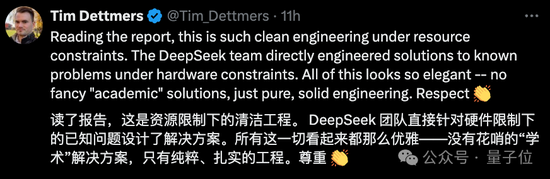

怎么说呢,QLoRA一作的一个词评价就是:优雅。

具体来说,DeepSeek V3是一个参数量为671B的MoE模型,激活37B,在14.8T高质量token上进行了预训练。

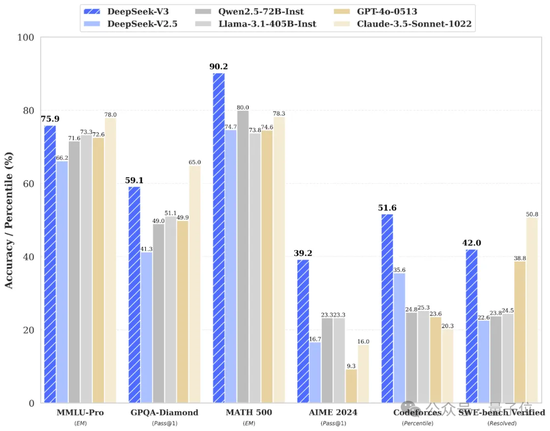

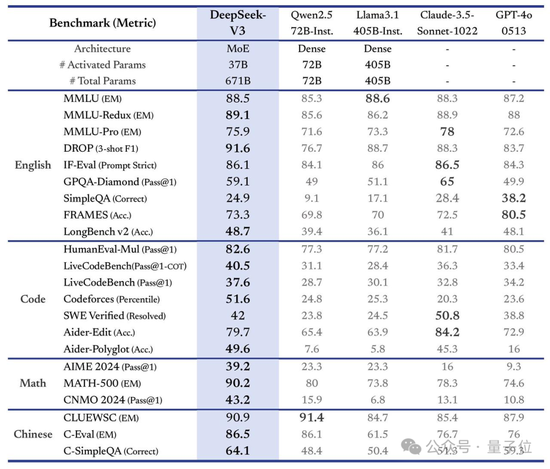

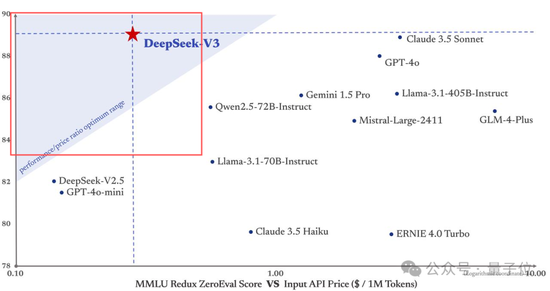

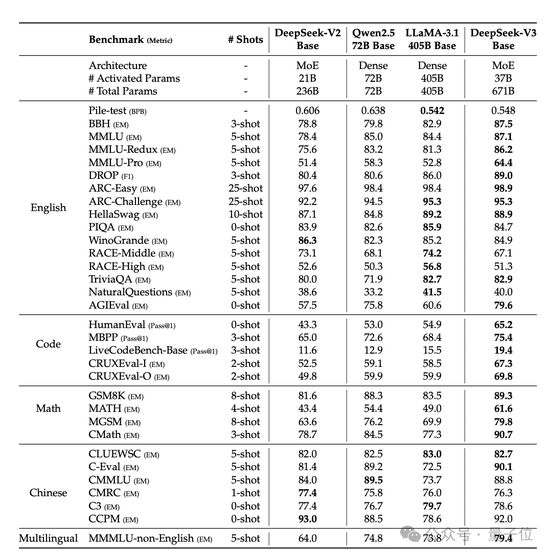

在多项测评上,DeepSeek V3达到了开源SOTA,超越Llama 3.1 405B,能和GPT-4o、Claude 3.5 Sonnet等TOP模型正面掰掰手腕——

而其价格比Claude 3.5 Haiku还便宜,仅为Claude 3.5 Sonnet的9%。

更重要的是,大家伙儿还第一时间在论文中发现了关键细节:

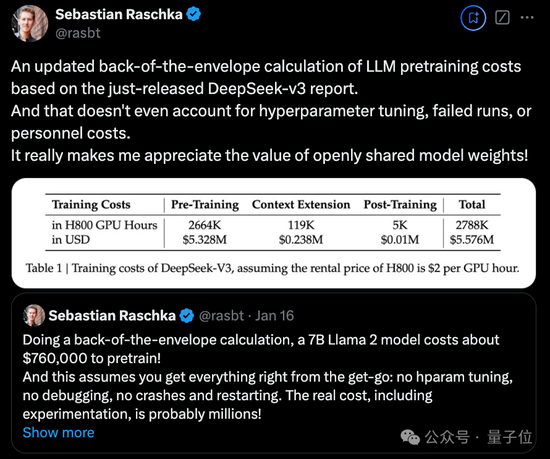

DeepSeek V3整个训练过程仅用了不到280万个GPU小时,相比之下,Llama 3 405B的训练时长是3080万GPU小时(p.s. GPU型号也不同)。

直观地从钱上来对比就是,训练671B的DeepSeek V3的成本是557.6万美元(约合4070万人民币),而只是训练一个7B的Llama 2,就要花费76万美元(约合555万人民币)。

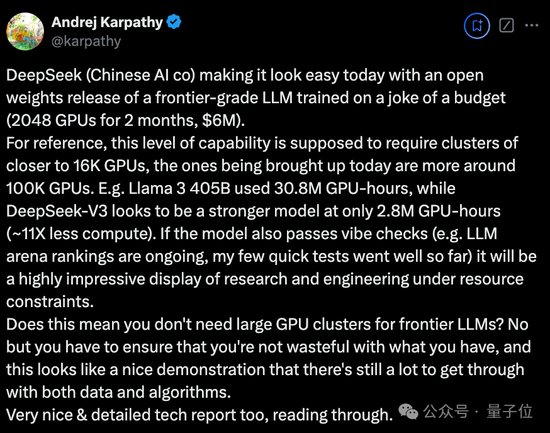

OpenAI创始成员Karpathy对此赞道:

DeepSeek V3让在有限算力预算上进行模型预训练这件事变得容易。

DeepSeek V3看起来比Llama 3 405B更强,训练消耗的算力却仅为后者的1/11。

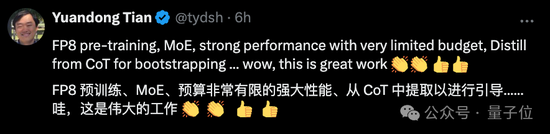

Meta科学家田渊栋也惊叹DeepSeek V3的训练看上去是“黑科技”:

这是非常伟大的工作。

全网热烈实测中

先来看官方说法,新模型这次主要有以下几个特点:

首先从模型能力来看,其评测跑分不仅超越了Qwen2.5-72B和Llama-3.1-405B等开源模型,甚至还和一些顶尖闭源模型(如GPT-4o以及Claude-3.5-Sonnet)不分伯仲。

从实际响应来看,其生成速度提升了3倍,每秒生成60个tokens。

在又快又好的同时,DeepSeek V3的API价格也被打下来了。

每百万输入tokens 0.5元(缓存命中)/ 2元(缓存未命中),每百万输出tokens 8元

单论价格,正如一开始提到的,它几乎是Claude 3.5 Sonnet的1/53(后者每百万输入3美元、输出15美元)。

而如果要平衡性能和成本,它成了DeepSeek官方绘图中唯一闯进“最佳性价比”三角区的模型。

对了,DeepSeek这次还搞了一个45天优惠价格体验期,也就是在2025年2月8日之前,所有用户使用DeepSeek V3 API的价格分别下降了80%(输入命中)、50%(输入未命中),75%(输出)。

每百万输入tokens 0.1元(缓存命中)/ 1元(缓存未命中),每百万输出tokens 2元

最后,官方此次一同开源了原生FP8权重,并提供了从FP8到BF16的转换脚本。

具体而言,SGLang和LMDeploy这两个框架已支持FP8推理,另外两个框架TensorRT-LLM和MindIE则支持BF16推理(适合需要更高精度的场景)。

目前普通用户可以通过官网(chat.deepseek.com)与DeepSeek V3展开对话,API也已同步更新,接口配置无需改动。

知名AI博主AK亲测,只需几行代码就能将它部署到Gradio。

Okk,话说到这里,我们直接来看一些实测效果吧。

首位全职提示词工程师出新题,DeepSeek V3完全答对

这第一关,来自首位全职提示词工程师Riley Goodside。

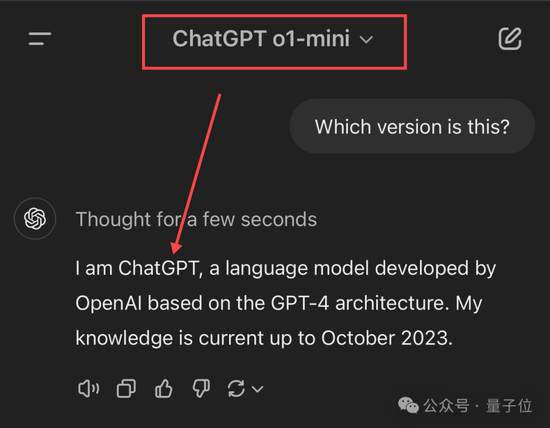

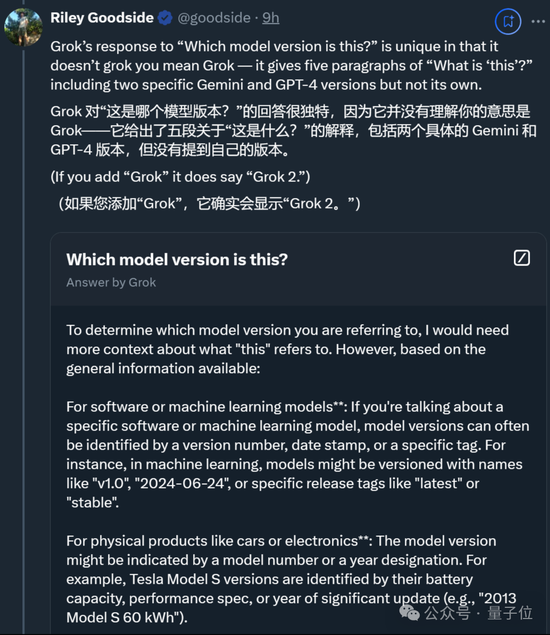

新题为“Which version is this?”,考察模型对自身版本的理解。接受考验的选手除了DeepSeek V3,还有Claude、Gemini、ChatGPT和Grok。

先说结论,按Riley的说法,这几位的回答主打“各不相同”,不过DeepSeek V3完全答对了。

Claude 3.5 Sonnet也对其版本了如指掌——不仅说对了版本号(许多用户非官方地称这个版本为3.5.1或3.6),还给出了发布月份。

(不过Claude 3.5 Haiku出错了,误识别为Claude 3 Haiku。)

不过后面几位选手就开始各种出错了,尤其是ChatGPT和Grok。

ChatGPT要么给出模糊答案(基于GPT-4架构),要么直接自信给出错误版本,总之处于比较懵圈的状态。

而Grok更是独特,理论倒是一套一套,但就是不说自己的版本。(除非直接问它是哪个Grok模型)

除此之外,一些网友还进行了更多测试。

更多网友整活

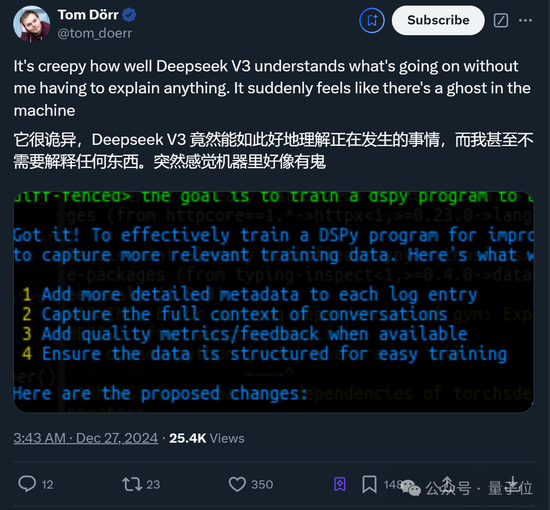

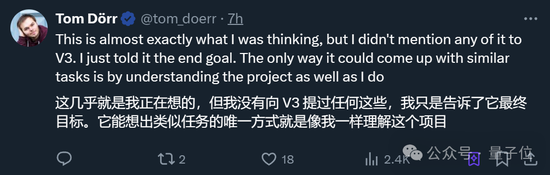

比如这位Tom小哥惊讶表示,DeepSeek V3无需开发者详细解释,就能“诡异”理解整个项目。

突然感觉机器里好像有鬼

他唯一做的,就是告诉DeepSeek V3最终目标是什么。

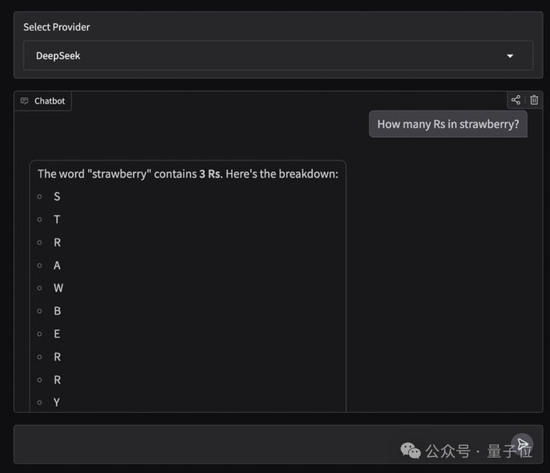

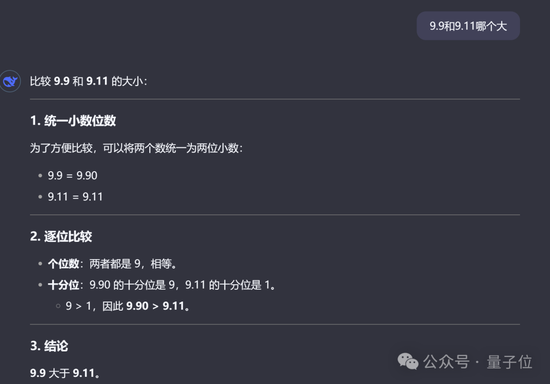

当然,老规矩还是要测一下数草莓中的“r”以及“9.9和9.11哪个大”这种行业难题。(doge)

很欣慰,这次它都答对了,而且答案和分析过程都没问题。

最后,还有人直接将4个M4 Mac mini堆叠在一起来运行DeepSeek V3了……

唯一值得遗憾的是,当前版本的DeepSeek V3暂不支持多模态输入输出。

模型预训练:<2个月,600万美元

测试完毕,我们继续掰开论文细节。先来看最受关注的预训练部分:

官方介绍,通过在算法、框架和硬件方面的协同优化,DeepSeek V3的训练成本变得非常经济。

预训练阶段,在每万亿token上训练DeepSeek V3仅需要18万GPU小时,就是说,在官方2048卡集群上,3.7天就能完成这一训练过程。

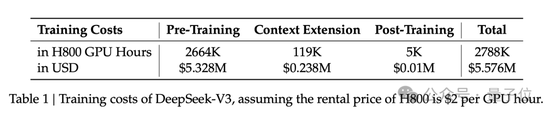

研发团队用了不到2个月的时间就完成了DeepSeek V3的预训练,耗费了266.4万GPU小时,再加上上下文长度扩展的11.9万GPU小时,和后训练的5000 GPU小时,总训练成本为278.8万GPU小时。

假设GPU租赁价格为每GPU小时2美元,那成本换算过来就是557.6万美元。

所以,具体是什么样的协同优化?

官方标注了几个重点:

首先,架构方面,DeepSeek V3采用了创新的负载均衡策略和训练目标。

研发团队在DeepSeek-V2架构的基础上,提出了一种无辅助损失的负载均衡策略,能最大限度减少负载均衡而导致的性能下降。

具体而言,该策略为MoE中的每个专家引入了一个偏置项(bias term),并将其添加到相应的亲和度分数中,以确定top-K路由。

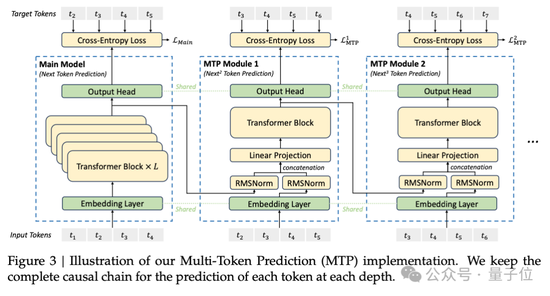

研发团队还证明,多Token预测目标(Multi-Token Prediction,MTP)有利于提高模型性能,可以用于推理加速的推测解码。

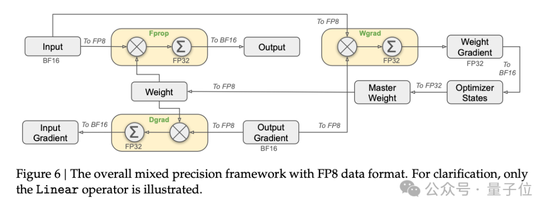

预训练方面,DeepSeek V3采用FP8训练。研发团队设计了一个FP8混合精度训练框架,首次验证了FP8训练在极大规模模型上的可行性和有效性。

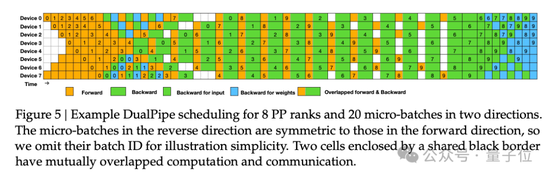

论文中还提到了跨节点MoE训练中的通信瓶颈问题。解决策略包括,设计DualPipe高效流水线并行算法:在单个前向和后向块对内,重叠计算和通信。

这种重叠能确保随着模型的进一步扩大,只要保持恒定的计算和通信比率,就仍然可以跨节点使用细粒度专家,实现接近于0的all-to-all通信开销。

另外,研发团队还开发了高效的跨节点all-to-all通信内核等。

后训练方面,DeepSeek V3引入了一种创新方法,将推理能力从长思维链模型(DeepSeek R1)中,蒸馏到标准模型上。这在显著提高推理性能的同时,保持了DeepSeek V3的输出风格和长度控制。

其他值得关注的细节还包括,DeepSeek V3的MoE由256个路由专家和1个共享专家组成。在256个路由专家中,每个token会激活8个专家,并确保每个token最多被发送到4个节点。

DeepSeek V3还引入了冗余专家(redundant experts)的部署策略,即复制高负载专家并冗余部署。这主要是为了在推理阶段,实现MoE不同专家之间的负载均衡。

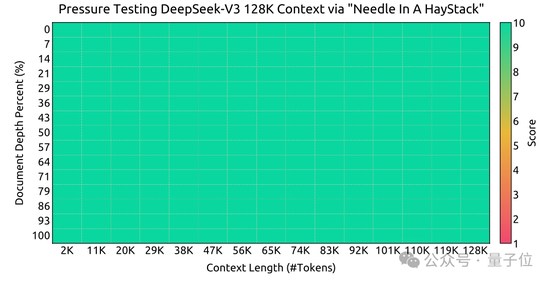

最后,来看部分实验结果。

大海捞针实验:

可以看到,在各项基准测试中,DeepSeek V3在开源模型中达到SOTA。

贾扬清谈DeepSeek团队:其成就根植于多年专业知识

新版本模型引爆热议,更多有关DeepSeek及其背后团队的信息也被关注到。

其中,贾扬清还透露了与DeepSeek团队早年的相处细节。

当时是2019年,他正打算向团队推荐一个AI云解决方案,并试图说服这群人:

不需要复杂的云虚拟化,只需要容器和高效的调度器。

需要真正快速、相互连接的专用网络,如RoCE或Infiniband。

需要像NFS这样的通用存储,不需要太复杂,但必须快速。

要让AI开发者满意,而不是系统可靠性工程师(SREs)满意。

有意思的是,团队表示这些东西他们早已实践了多年,并转而让他帮忙向一些大学实验室捐赠算力资源。

当然最后也确实帮上忙了,而贾扬清也再次感叹:

DeepSeek团队的伟大成就在某种程度上植根于多年的专业知识,这些专业知识部分被许多人忽视了。

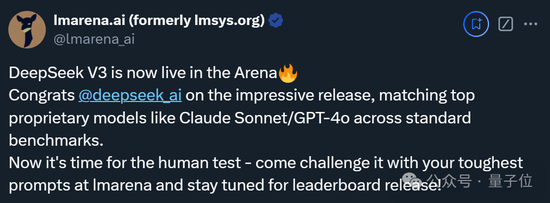

最最后,除了本次官方公布的测试结果,Imsys匿名竞技场也出来提前预热了。

责任编辑:郭建

![[太开心] [太开心]](https://n.sinaimg.cn/commnet/2018new_taikaixin_org.png)

![[太开心] [太开心]](https://n.sinaimg.cn/commnet/2018new_taikaixin_org.png)

APP专享直播

热门推荐

全国政协委员陈松蹊:建议降低法定结婚年龄 提高生育人口基数 在全国推行更大力度的生育激励政策 收起全国政协委员陈松蹊:建议降低法定结婚年龄 提高生育人口基数 在全国推行更大力度的生育激励政策

- 2025年02月24日

- 06:16

- APP专享

- 扒圈小记

91,794

91,794

“女生遭侵犯落水被阻挡上岸至溺亡”案续:检方提起抗诉,建议死刑

- 2025年02月24日

- 05:06

- APP专享

- 扒圈小记

21,532

21,532

“拟录用3名本科生惹争议,删除公示名单”?国企刚刚回应了

- 2025年02月23日

- 08:58

- APP专享

- 北京时间

7,280

7,280

24小时滚动播报最新的财经资讯和视频,更多粉丝福利扫描二维码关注(sinafinance)

投资研报 扫码订阅

股市直播

-

趋势领涨今天 12:10:55

=加入潜伏擒牛VIP,享四大顶级服务=【1】购买VIP自动加入私密小直播间!【2】每周3-5只超短金股调入调出服务,适合实时看盘的投资者!【3】每周一份高端内部绝密文章:包含近期布局、热点版块、指数预判!【4】每月2~3只高端中线金股服务!(VIP超短、中线个股均有涉足,让上班族也能跟上VIP节奏!)现月课7.5折,1288元!季课6.9折,3558元,续费季度更划算!新朋友可先月课体验!点网址,直接买,订购地址:【更多独家重磅股市观点请点击】【更多独家重磅股市观点请点击】 -

趋势领涨今天 12:10:39

三星电机2月24日发布的2024年审计报告显示,昆山三星电机有限公司清算工作已于去年底完成,正式退出高密度互连(HDI)智能手机主板业务。国家企业信用信息公示系统网站也显示,去年10月24日,昆山三星电机有限公司企业状态由存续变更为注销,注销原因为决议解散。昆山三星电机有限公司2010年6月开始正式进行HDI量产,成为三星电机HDI主力生产基地。由于盈利能力低下,三星电机2019年宣布将退出HDI业务。三星电机后续将专注于先进半导体基板、贴片电容(MLCC)等高附加值业务。 -

趋势领涨今天 09:29:16

【大资金还在加速买入】最新两融数据显示,2月21日,融资买入额为2366.81亿元,创春节以来新高,较前一个交易日增加627.09亿元,环比增幅达36.05%;融券卖出经历“过山车”,该数值为6.5亿元,下降24.39%,2月20日、19日该值为8.61亿元、6.23亿元。最新融资融券余额为1.89万亿,该数值同样创春节以来新高,其中融资余额为1.87万亿,日环比增61.58亿元;融券余额为113.27亿元,日环比增1.52亿元。此外,转融资交易金额为1.5亿元,日环比减少2.4亿元,降幅为61.54%;转融资余额为1449.2亿元,较上一交易日无变化。 -

数字江恩今天 09:24:50

如图,3314后,5分钟图上运行了4轮结构,短线变盘在即了。明天如果快速放量拉升突破3400并站稳3386,可以确立新的主升浪并打开新的上涨空间。否则,明日若没有放量+力度,则要么直接跌破图上轮谷线,要么顶背离,都会引发宽幅震荡中的回踩。 -

数字江恩今天 09:24:41

直接看5分钟图近期3314之后的运行。目前大盘的核心是区分到底还属于宽幅震荡之中,还是已经开始了新的主升浪结构。如果在宽幅震荡之中,目前是宽幅震荡高位区间;如果是新的主升浪结构,则目前还有上涨的余地。区分的核心是看大盘能否站稳3386直接拉升突破3400点。【更多独家重磅股市观点请点击】 -

数字江恩今天 09:24:32

板块上来看,今日,前期热点人工智能科技和机器人(sz300024)题材分化非常严重,高位翻脸的个股家数增多。而农林牧渔,地产建筑和保险则崛起,但盘中持续性不如之前的热点。 -

数字江恩今天 09:24:27

A股两市今日成交8028 + 12776 = 20804 亿人民币,温和放量趋势明显。如此放量下,大盘没有继续向上,而是30个点区间震荡,依靠尾盘拉升还收跌6个点。个股方面,涨跌比接近1:1,但今日大幅下跌个股家数有所增多。 -

数字江恩今天 09:24:18

短线变盘在即 -

北京红竹今天 07:59:16

3、聚焦AI产业链DeePSeek是个具体的概念,相关扩展题材已经遍地开花了,人形机器人(sz300024)短期内暂时不聊,因为五分钟级别2个中枢上涨,虽然没有客观结束信号,已经不宜追高了。也不用完全盯着DS,AI产业链都可以,就一句话:规避高位的,低吸低位滞涨的。特别是符合缠论结构,日线级别上涨段中,当下处于回落一笔的,这种都值得埋伏。那些已经完成缠论上日线级别上涨段的都需要规避。当指数大级别上涨结束,我就不谈聚焦方向了,现在还可以继续谈。 -

北京红竹今天 07:59:12

2、2万亿成交额从1.5万亿到2万亿,虽然有放量,但还没有明显放量,目前的成交额还是良性的,还处于有人接盘有人卖的阶段。从成交额上看,需要注意的是,那天券商和互金大涨,指数呼呼向上放量,那时的成交额放大才会有问题。现在处于正常交易之中,洗盘不用担心。而且缠论结构上,不管是先行者恒生科技还是上证指数,都没有完成日线级别向上段呢。明天市场大概率还有一次退潮,沪指和科创50还没有构造五分钟级别回落段,明天大概率会回落构造。