网友很好奇,Mathstral能不能搞定「9.11和9.9谁大」这一问题。

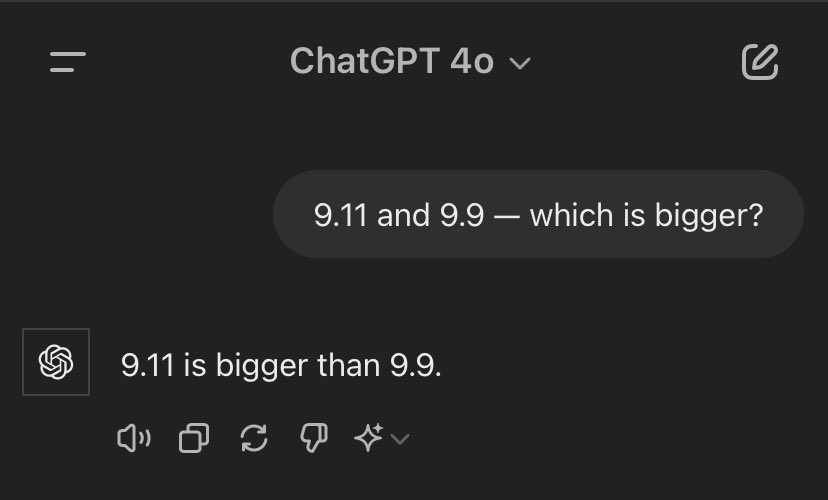

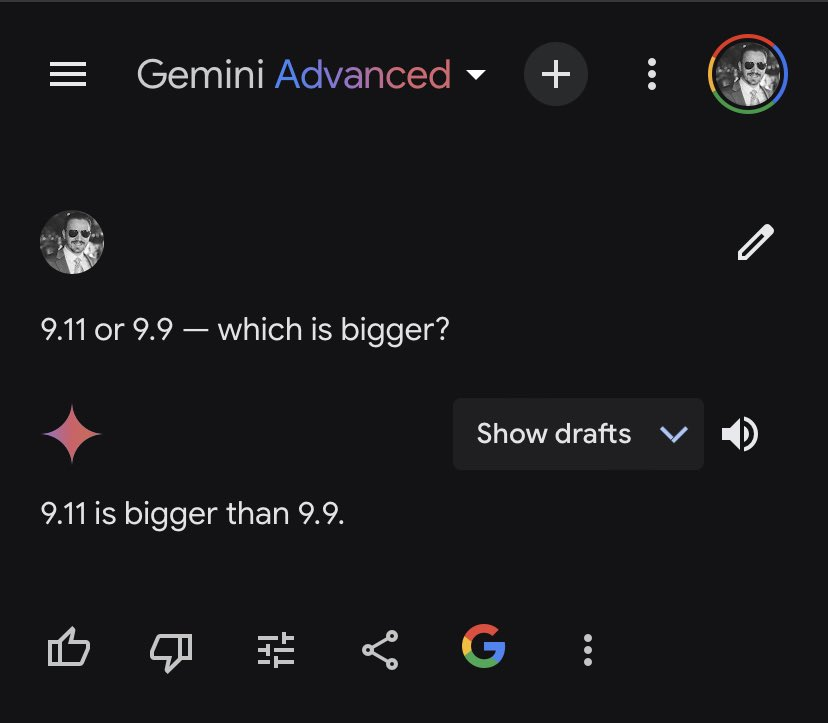

昨天,AI圈竟然被「9.11和9.9谁大」这样简单的问题攻陷了,包括OpenAI GPT-4o、Google Gemini等在内的大语言模型都翻了车。

这让我们看到,大语言模型在处理一些数字问题时并不能像人类那样理解并给出正确的答案。

对于数字以及复杂的数学问题,专用模型更术业有专攻。

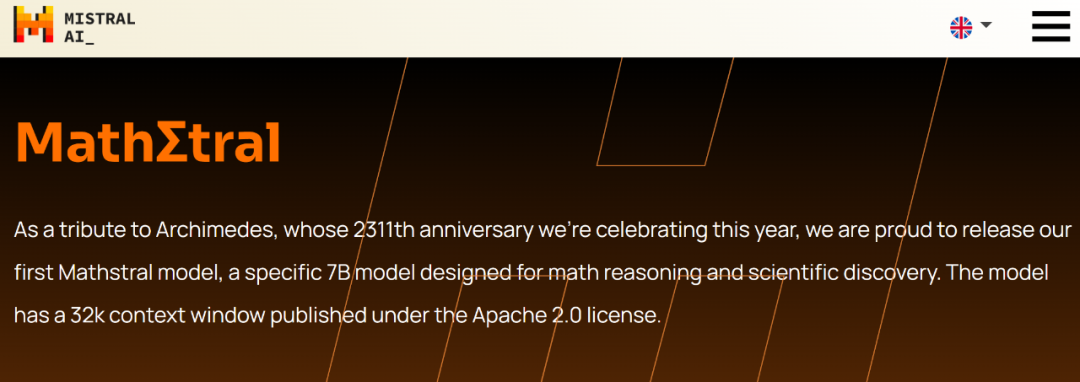

今天,法国大模型独角兽 Mistral AI 发布了一个专注于数学推理和科学发现的7B大模型「Mathstral」,来解决需要复杂、多步骤逻辑推理的高级数学问题。

该模型基于 Mistral 7B 构建,支持的上下文窗口长度为32k,遵循的开源协议为Apache 2.0 license。

Mathstral在构建时追求出色的性能与速度权衡,这是 Mistral AI积极推广的一种开发理念,尤其是微调功能。

同时,Mathstral是一个指令型模型,可以使用它或者对它进行微调。模型权重已经放在了HuggingFace上。

模型权重:https://huggingface.co/mistralai/mathstral-7B-v0.1

下图为 Mathstral 7B和Mistral 7B之间的MMLU性能差异(按学科划分)。

Mathstral在各种行业标准基准上都达到其规模范围内的 SOTA 推理性能。尤其是在MATH数据集上,它取得了 56.6%的通过率,在MMLU上取得了63.47%的通过率。

同时,Mathstral在MATH上的通过率(56.6%)比 Minerva 540B 高出 20% 以上。此外,Mathstral 在MATH 上以多数投票@64的成绩得分为68.4%,使用奖励模型的成绩为 74.6%。

这一成绩也让网友好奇,Mathstral能不能搞定「9.11和9.9谁大」这一问题。

代码大模型:Codestral Mamba

模型权重:https://huggingface.co/mistralai/mamba-codestral-7B-v0.1

与Mathstral 7B一同发布的,还有一款专门用于代码生成的Codestral Mamba模型,使用的是Mamba2架构,同样遵循Apache 2.0 license开源协议。这是一个指导模型,有70多亿参数,研究者可以免费使用、修改和分发。

值得一提的是,Codestral Mamba是在Mamba作者Albert Gu、Tri Dao帮助下设计完成的。

一直以来,Transformer 架构撑起了AI领域的半壁江山,然而,与 Transformer 不同的是,Mamba 模型具有线性时间推理优势,并且理论上能够对无限长度的序列进行建模。该架构允许用户广泛地与模型互动,并且响应迅速,而不受输入长度的限制。这种效率对于代码生成尤其重要 。

在基准测试中,Codestral Mamba 在 HumanEval 测试中的表现优于竞争对手开源模型 CodeLlama 7B、CodeGemma-1.17B 和 DeepSeek。

Mistral 测试了该模型,该模型可以在 Mistral 的 la Plateforme API 上免费使用,可处理多达 256,000 个token的输入——是 OpenAI 的 GPT-4o 的两倍。

随着Codestral Mamba发布,就有网友在 VSCode中用起来了,很是丝滑。

“掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)