视频生成有可能是2024年大模型最火的赛道。

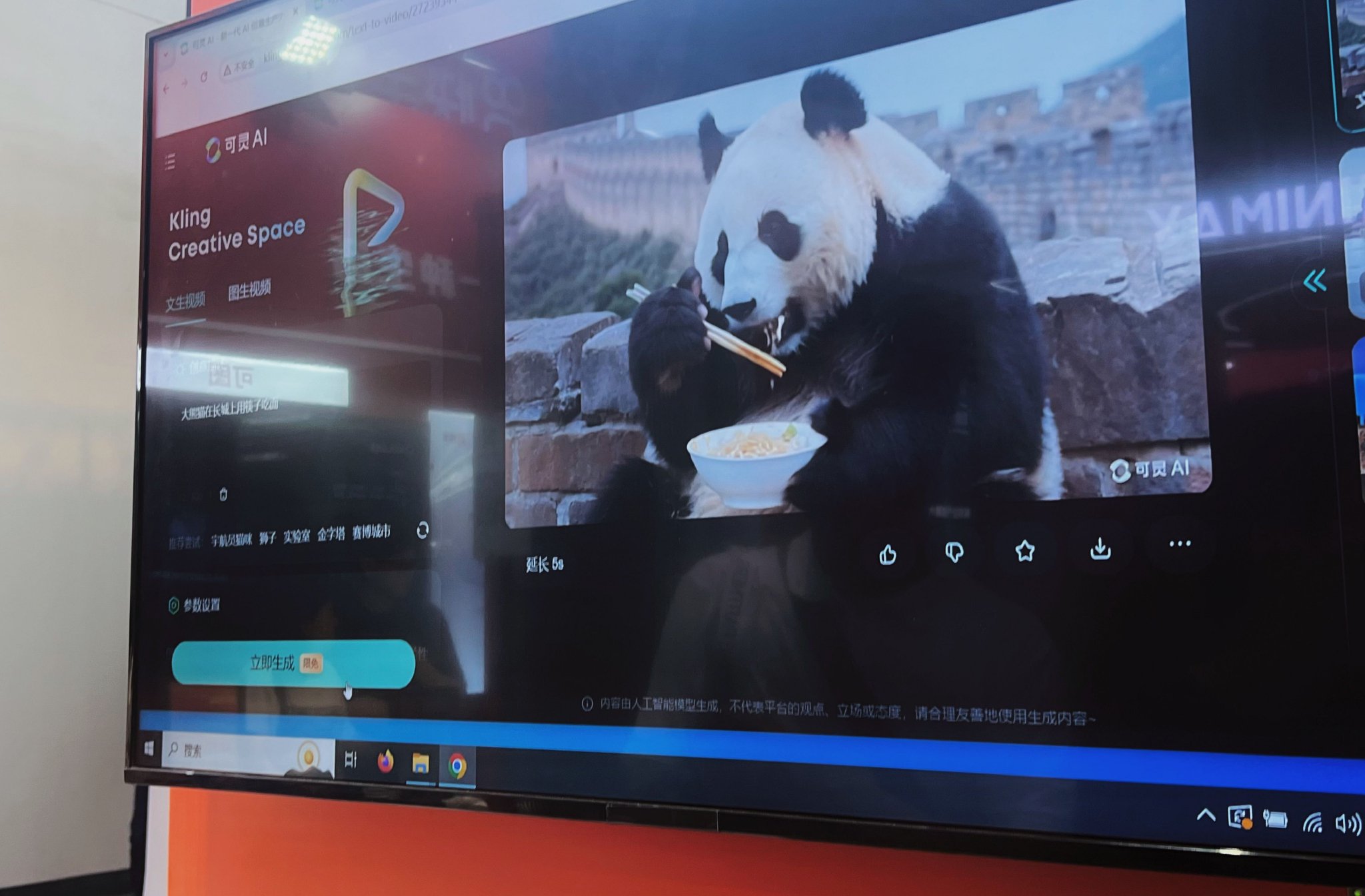

在WAIC(世界人工智能大会)上,快手展台隐藏在展馆边缘,快到闭馆的时间,记者在其视频生成模型“可灵”的展位参观,几次被热情的提问者挤开,感兴趣的参观者们围着工作人员抛出各类问题,闭馆音乐响起时,这种热情丝毫没有减少,直到工作人员关闭设备开始“赶人”。

这把火最初是由Sora点燃的,今年2月,OpenAI发布的视频大模型Sora引发轰动,宣告了视频领域“百模大战”的开始。今年以来,国外有Runway、Pika、LumaAI,国内有爱诗科技PixVerse、生数科技Vidu、快手可灵等,大模型“卷”的方向已经从文字、图片来到视频。

不过,视频生成还处于一个早期阶段,技术路线尚未达成共识、生成过程难以控制、生成效果离商业标准还有距离都是问题,不少行业人士都将其与语言、图像模型的早期阶段作类比。

新加坡南洋理工大学助理教授刘子纬认为,视频生成处于大语言模型GPT-3左右的时代,那时距离3.5和ChatGPT的爆发点还有半年左右的时间。智子引擎CEO高一钊则认为,目前的视频生成有点像图像生成的2022年前夕,Stable Diffusion开源之前,因为视频生成领域目前还没有一个特别厉害的开源“Sora”发布。

不少创业者已经开始探索落地,毕竟,等成熟了再做就晚了,过去每一轮新技术出现,“都是在大家看不懂的时候先上”。

还在“GPT-3”时代

“过去一年对于AI视频生成来说是一个历史性的时刻,一年前市面上还很少有面向公众的文生视频模型,短短几个月内我们目睹了几十款视频生成模型的问世。”阿里巴巴达摩院视频生成负责人陈威华在不久前一场论坛上提到。

在今年2月Sora发布后,叫得上名字的产品发布就有不少:4月生数科技发布视频大模型Vidu,6月快手发布AI视频生成大模型可灵,一周后Luma AI发布文生视频模型Dream Machine,Runway在7月初宣布,文生视频模型Gen-3 Alpha向所有用户开放使用。

除了密集的产品发布外,头部视频生成模型公司也相继拿到融资。3月,爱诗科技完成亿级A1轮融资,由达晨财智独家投资,随后生数科技也宣布完成一轮数亿元融资,由启明创投领投。6月,Pika完成总额8000万美元的B轮融资,7月,有消息称Runway正计划以大约40亿美元的估值募集4.5亿美元。

虽然融资和产品发布很热闹,但在前方用户体验层来看,目前的视频生成结果远远达不到预期。“现在视频生成就是抽卡,抽100次才能抽出一个比较好的结果。”刘子纬比喻道。

第一财经记者曾使用多个视频模型体验,生成的画面有时会出现行走的人双脚交替时消失部分腿、背对镜头的人的脑后会出现脸,或者一对男女在跳舞旋转时人脸交换的混乱情况,此外,生成等待的时间短则1-2分钟,长的能在1小时以上。

这种情况并非个例,OpenAI曾邀请了一些视频制作团队对Sora进行试用,其中一个团队利用Sora制作了一部《气球人(Air Head)》的短片,效果非常惊艳。但5月这部作品的制作团队在接受采访时提到Sora“生成过程很难控制”,整个短片由多个视频片段组成,但是在生成不同视频片段时很难保证主角始终是这个长着黄色气球脑袋的人,有时候上面会出现一张脸,有时候甚至气球不是黄色的。因此整个短片并不是Sora直接输出的结果,其中引入了大量的人工后期编辑才能呈现出最终的效果。

在WAIC论坛上,美图公司高级副总裁陈剑毅也曾“吐槽”AI视频生成:宣传都很好,实际不好用。他提到,现在社媒上很多KOL背后做了很多工作,可能生成了几百条视频,有一条视频良品率高,“抽”出很好的效果,他将这个效果做了很多后期处理发布,用户看的时候会觉得现在AI视频技术已经很成熟了,但其实现状和我们想象中还有一两年代差。

目前视频、图像、三维的生成类算法会遇到很多结构性和细节性问题,如通常会多长出一样东西或者少一样东西,或者手穿模到人身体里,这类精细化的视频、尤其是具有物理规则的视频目前很难生成。

究其原因,上海交通大学电子系教授、博士生导师倪冰冰认为,所有的生成式智能本质上来说是一个采样的过程,视频是一个比图像更高维度的空间。如果我们给予更多的训练数据,将采样精度降得更低,我们可以生产出更好的内容,但这是有天花板的,“因为我们维度空间太高了,一定要做到万无一失、千真万确,以目前的技术框架是有一定难度的。”在这背后,算力就是一个很大的约束,不可能用无限制的大算力采样的方式去解决问题。

陈剑毅将目前的视频生成阶段与电影发展史类比,“最初的电影就是一组连续的照片,一秒钟24张照片连续动起来,拍了几千张照片,最终做成了1分钟的黑白电影。当下的AI视频生成技术还在早期阶段,其实就是和当年1分钟黑白电影的起点是类似的。”他预测,视频生成或许短期内会经历从原始到高级的快速演变,用3-5年时间就走完电影技术百年发展史。

高一钊认为,目前的视频生成有点像图像生成的2022年前夕,“22年8月Stable Diffusion开源后,AIGC图像生成开始爆发,但视频生成领域目前还没有一个特别厉害的开源Sora发布。”

刘子纬则将当下的视频生成进展类比大语言模型的阶段,“目前有点像GPT-3左右的时代,距离3.5和ChatGPT的爆发点还有半年左右时间,但应该已经不远了。”如果类比文生图,会发现,最开始的一代到最后大规模爆发应用也只花了一年半时间,刘子纬认为,视频领域有很多资本已经进场,数据、算力充分的情况下,这个爆发的时间点会很快。

启明创投近日发布了一个“2024生成式AI十大展望”,其中一条是,3年内视频生成将全面爆发,报告认为,结合3D能力,可控的视频生成将对影视、动画、短片的生产模式带来变革。未来图像和视频隐空间表示的压缩率提升五倍以上,从而使生成速度提升五倍以上。

Sora不一定是完美方案

相比大语言模型的技术路线已近趋同,视频生成当下还面临的一个重要问题是,技术路线还未达成共识,就目前的团队来看,还有多种不同的技术路线同时在进行,业内认为,Sora并不一定是最优方案,未来很可能出现新的团队拿出不同的“解法”。

“去年大家还普遍基于SD(Stable Diffusion)做图像和视频生成,但今年Sora一出现,大家都觉得要改成类Sora的DiT(DiffusionTransformer)架构了。”高一钊对第一财经表示,从这个事能看出来,视频生成领域并不像文本领域那么成熟,也不是那么固化的一个技术方向,还要不断做创新。

就技术路线来说,高一钊认为,Sora并不一定是一个完美的解决方案,它只是比上一代的方案更好,有一定的优势,“但是说不准年底或者明年就有新的架构出来了。”

视频生成现在有几条不同路径。一条是最初的Diffusion模型,沿着文生图,将文生图拓展到时间维度;其次是追随Sora,基于Transformer做DiT架构;还有一种路线是用大语言模型的方法将视频和视觉内容重做一遍,即采用大语言模型(LLM)的自回归架构,谷歌团队去年底发布的视频生成模型VideoPoet就是基于LLM来实现视频生成的。

刘子纬认为,如果是做短视频,如3-4秒让图片动起来,Diffusion模型的技术就已经够用,但如果想做更长的视频,如10-20秒量级,DiT架构仍然有更大的优势,这种技术路径对于长文本或长视频的理解能力会更强,生成能力也更好。但即便是Sora的DiT架构,对物理、世界模型的理解还不够,因此部分团队也试图利用语言模型里学到的知识帮助生成视觉的世界。

“这条路(自回归架构)目前看起来视觉效果还比不上另外两条,但我个人觉得它的上升轨迹会非常快,可能到年底会发现用语言模型做生成也会是比较好的,那个时候我们会真正地将所有的模态融合到一起。”刘子纬发现,在训练成本上,Diffusion比较低,而自回归较高,但自回归一旦训练好了,推理方面的成本优势会很大。

当下大模型的算力的约束还很大,倪冰冰认为,未来可能需要有一些新的架构、新的计算方式或新的底层技术来支撑一个更高效的生成方法。

神经网络的黑盒化是当下大量消耗数据算力资源的问题核心,“对于生成的网络我们完全不知道这里哪一个节点和我们要生成、控制的内容有关,不知道输入的某一个词到底在这样一个节点里哪几个单元是有关联的,我们也不知道我们输出的人脸某个地方的形状和神经网络里面哪几个单位是有关的。”倪冰冰表示,当下需要的是白盒化的生成技术,如果能将视频中的内容对应到网络参数,我们就可以精确地操控生成的内容,在这背后,要解决参数对齐的问题,数据内容的表征问题。

当下Sora是视频领域的王者,自从发布后一直是国内追赶的目标。高一钊认为,只谈底层技术方面,我们距离Sora没有差很远,更决定性的是资源的投入差距,以及产品搭建方向上的思考。

“国内新的一些创业团队,其实和世界上最顶尖的做大模型的团队在底层技术上没区别,都是那一套架构,”高一钊认为,但如果要谈产品谈应用,那就会有非常多的细节,“比如这些技术要怎么把应用做好,为了把应用做好,该搭哪些技术,这些都是很困难的事情。”

上个月Runway发布了全新文生视频模型Gen-3 Alpha,其中一个案例视频是,在高速行驶的火车车窗旁一名女子的侧影,火车在飞速行驶中,车窗外的霓虹灯照在女人脸上,在她的脸颊、鼻子上都有不同层次的效果,这些快速变化的光影在人物的脸上变换非常自然逼真。

高一钊猜测,Runway这样的效果主要是通过针对性地数据训练达成的。“Runway一开始就做了非常多专门训练光影的数据,这其实就是产品方向,团队认为这个产品要真正解决需求,光影必须要自然,所以他们会就很多针对性的方向进行训练。”他认为,产品层和技术层是两套思维。

在视频生成这一领域中,刘子纬未来希望探索“视频生成牛顿第一定律”。他提到,对语言模型来说,目前投入多大算力、用多少数据就能获得多大增益,这种投入产出比是能算出来的,对资本方、产业和应用都是很好的点,但是对于视频生成和多模态来说,目前还没有很明确的标准,多大算力能得到多大提升,这是很本质的问题。此外,在架构方面,自回归或者DiT是否一定是终局,训练成本能否降低都是待探索的问题。

“在大家看不懂的时候先上”

在一场论坛中,谈及视频生成的商业模式,五源资本副总裁石允丰较为谨慎,他判断,就现在视频生成的效果来说,“在流沙上建城堡非常有挑战”,技术底座并没有稳固下来,这时候找PMF(产品市场契合点)挑战很大。

“普通人也能用的视频生成工具,会观察到用户是非常不忠诚的,在不同APP之间跑得非常快。Luma发布了之后4天之内获得了100万用户,这100万用户之前或多或少都已经用过PIika,意义不大。”石允丰认为,今天视频生成是有创作者的,但问题在于,较成熟的内容消费还没出来。

相比投资方的观望,更多的创业者则是另一种“实干派”。

“过去每一轮新的东西出来,绝对不是等成熟了再来做,这样就晚了,都是大家看不懂的时候先上。”FancyTech创始人空界(花名)表示。

FancyTech目前是自研视频和图像模型,聚焦于ToB,为商家生成基础素材,替代基础拍摄的部分,如对商品、物品、模特等的拍摄。空界在论坛上提到,FancyTech去年营收接近1000万美元,今年预计会到两三千万美元。

“我们觉得现在就是很好的应用时间点,”谈到应用落地,空界表示,“要赚钱,要留在牌桌上,能够保证有这样的收入,当不断有新的技术涌现出来的时候,我们在这个上面叠加,同时能够获得我们的特色。”

Morph AI创始人徐怀哲认为,不确定性是创业的巨大机会和意义。“任何一个大公司都是从最开始成长起来的,留给他们的机会是每一个技术浪潮更新的时候,商业模式有巨大不确定性,如果知道答案一步一步往前走,这一定是一个大厂大公司的机会。”

“赶热点是一回事儿,但是更多的还是要产生实际价值。”就今年视频生成赛道的火热,高一钊认为,追随赛道顶流去跟进产品和投入是必然的,但国内也需要形成自己的一套打法和逻辑,在技术和资源上可能暂时落后,但在落地应用上,我们仍然有场景优势。

“AI领域的技术一旦开放,大家复制起来没有想象中那么困难,所以核心竞争点还是在应用上,在技术上差不多的情况下,怎么能深耕到某个领域,解决用户的真实需求。”高一钊认为,应用落地是全世界AI从业者都要回答的问题。

目前,智子引擎第一个选择的落地场景是城市巡检。“无人机等设备会拍下来一些视觉内容,将这些视觉内容传回给我们的大模型进行分析。”高一钊表示,在这样的场景下,大模型的通用性具有的优势是,能解决复杂真实环境的各种突发情况,如下雨刮风的天气情况,摄像头角度不对了等等,相比以往小参数的AI软件,大模型适用性更广。

就C端来看,陈剑毅判断,短期内没有诞生一个AI视频平台级的机会,“AI版的抖音目前来看不太可能”。但如果目光看向产业仍然有机会,他判断,现在AI视频的机会点不是传统的影视内容形式,而是在生成空镜素材、各种MV、故事绘本、网文短剧等方面。

“比如一个企业想拍宣传片,里面需要插入两三段自然风光,这时候就不需要做一些内容的实拍,用AI视频生成很快就能生成。” 陈剑毅认为,短期内很明显可以看到AI视频生成对各种空镜素材是很大的帮助,此外,在教学中,学生只要在提示词里面输入“我想看一看冰山融化的过程”,这时候视频生成就可以将复杂的物理知识通过直观视频展示出来。

井英科技创始人朱江有个有趣的类比,他认为现在的AI生成式时代,有点像寒武纪生命大爆发的时候。“今天很多动物的门类都是寒武纪大爆发的时候突然出现的,那个时代任何一个物种如果考虑未来能不能生存下去,其实都很难。”他提到,当时很大的变化是有一类生物突然进化出了眼睛,他们就取得了阶段性优势。

如何存活?朱江认为,创业公司能不能在新的生成式时代保持“Tire1”技术的水准和理解很重要,不管是做模型还是做应用,“因为新的机会和新的技术发展速度很快,如果等到成熟的时候再理解,可能作为一个创业公司来说商业机会就错过了。”

“掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)