在2024年美国加州圣荷西的GTC大会上,GPU巨头英伟达宣布推出号称目前最强大的AI芯片GB200,并计划于2024年晚期开始正式出货。

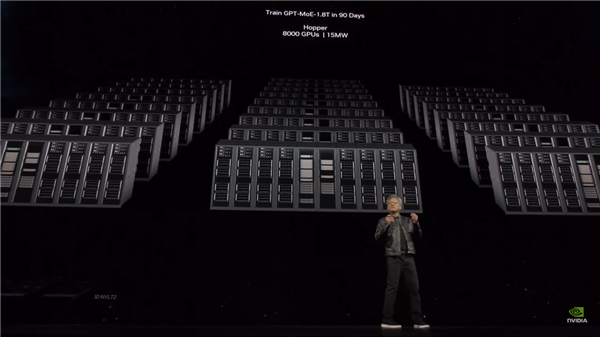

这款芯片采用了英伟达的最新Blackwell架构,公司创始人兼CEO黄仁勋表示,尽管两年前推出的Hopper架构GPU表现出色,但英伟达仍需要一款更强大的GPU来满足市场需求。

英伟达遵循每两年更新一次GPU架构的策略,以显著提升AI芯片的性能。继2022年发布的基于Hopper架构的H100 AI芯片之后,英伟达继续引领全球AI市场。

现在,搭载Blackwell架构的新AI芯片性能将更加强大,尤其是在处理AI任务方面,该架构得名于数学家David Harold Blackwell。

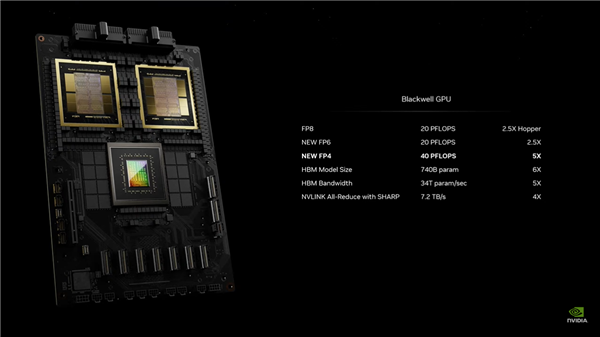

黄仁勋透露,Blackwell架构的AI运算性能在FP8和NEWFP6上可达到20 petaflops,是前一代Hopper架构的8 petaflops性能的2.5倍。

在NEWFP4上,性能更是达到了40 petaflops,是Hopper架构的5倍。根据不同设备配置的内存容量和带宽,实际性能可能还会更高。这种额外的处理能力将使人工智能企业能够训练更大、更复杂的模型。

采用台积电4纳米制程技术的Blackwell架构GPU体积庞大,集成了两个独立制造的裸晶(Die),共有2,080亿个晶体管,并通过NVLink 5.0接口连接。

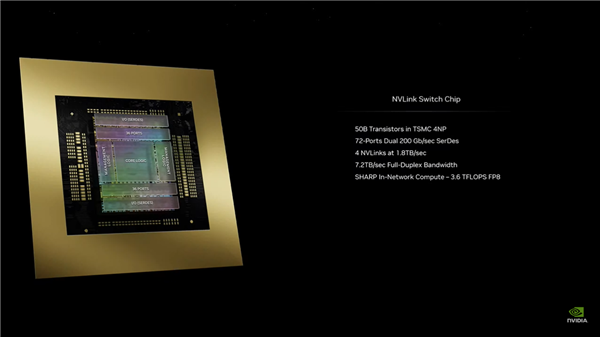

英伟达使用每秒10 TB传输速度的NVLink 5.0来连接两块裸晶,官方称该接口为NV-HBI。Blackwell complex的NVLink 5.0接口提供的带宽高达每秒1.8 TB,是前代Hopper架构GPU上NVLink 4.0接口速度的两倍。

黄仁勋进一步指出,新推出的GB200 AI芯片包含两个Blackwell GPU和一个基于Arm架构的Grace CPU。其推理模型性能比H100提升了30倍,同时成本和能耗降低到原来的1/25。

针对有大型需求的客户,英伟达提供完整的服务器产品,如GB200 NVL72服务器,配备了36个CPU和72个Blackwell架构GPU,以及一套完整的水冷散热方案,可实现高达720 petaflops的AI训练性能或1,440 petaflops的推理性能。服务器内部使用的电缆总长度接近2英里,包含5,000条独立电缆。

目前,亚马逊的AWS已计划采购由2万片GB200芯片组成的服务器集群,能够部署拥有27兆参数的模型。除了亚马逊的AWS之外,DELL、Alphabet、Meta、微软、OpenAI、Oracle和TESLA等也成为了Blackwell系列芯片的采用者。

责任编辑:振亭

“掌”握科技鲜闻 (微信搜索techsina或扫描左侧二维码关注)