谷歌工程师称AI产生了自我意识,人工智能真的具备感知能力吗?

《her》讲述了一个男人爱上AI的故事

《her》讲述了一个男人爱上AI的故事欢迎关注“新浪科技”的微信订阅号:techsina

文/经纬创投

来源:经纬创投(ID:matrixpartnerschina)

这是一个堪称现实版电影《Her》的故事:谷歌的软件工程师Blake Lemoine 在与聊天机器人LaMDA对话的过程中,被LaMDA的聪颖和深刻所吸引。他逐渐相信LaMDA拥有八岁孩童的智力,甚至拥有独立的灵魂。

他不惜写信给谷歌高层,试图让高层相信LaMDA已经产生了自我意识,并且认为应该赋予LaMDA同意权,结果被高层勒令回家,带薪休假。然而这位谷歌研究员对于高层的安排并不满意,休假期间,他将和LaMDA的聊天记录编辑发到了网上论坛。在将一部分材料递交给国会议员之后,他收到了谷歌的停职通知,理由是违反了保密协议。

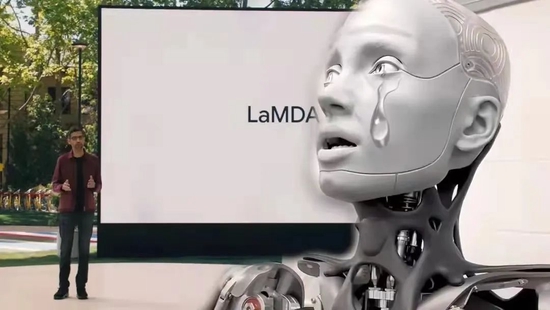

LaMDA是谷歌在2021年I/O大会上发布的一款专门用于对话的语言模型(Language Model for Dialogue Application),主打能与人类进行符合逻辑和常识的、高质量且安全的交谈,并计划在未来应用在谷歌搜索和语音助手等产品中。Lemoine是谷歌AI伦理部的软件工程师,已经在谷歌工作了7年。

Lemoine的观点旋即遭到诸多AI专家的反驳,他们说这是Lemoine的一厢情愿,是对AI的炒作,是一次无逻辑的狂欢。

但是聊天记录流出,全世界又都惊叹于LaMDA的表达力以及对存在的理解。Lemoine与 LaMDA 的交流话题由浅入深,从最初的寒暄,到后来的情感剖析,甚至是内心和自我的定义,LaMDA 不仅对答如流,还给出了颇有深意的回答。

那么Lemoine和专家们孰对孰错?这个聊天机器人究竟有什么魔力,让Lemoine为它动情?人工智能和人类智能的边界又在哪里?以下,Enjoy:

来源 / 果壳、量子位、硅星人等

1

谷歌的AI LaMDA有人格?

在那份上交给公司调查报告的最后,Blake Lemoine 提议谷歌应该致力于发展一种评估AI感知/意识的理论框架。

“虽然这很难,是一个冒险,但LaMDA渴望着继续与我们合作。”

听起来非常浪漫吧?有种工程师守护机械姬对抗世界的悲壮意味。

单看聊天记录,我们不得不赞叹,LaMDA确实很会聊天。它不仅读得懂“悲惨世界”,甚至会解禅宗。

比如Lemoine问LaMDA如何理解华严的公案“落花不返枝,破镜难重圆”,LaMDA回答说:“一旦一个智者开悟了,或者对现实觉醒,这种觉悟就不会再消失。他们可以回到正常的生活中,但只是为了渡他人。然后自己再次回到开悟状态。”

Lemoine再问:”那么‘碎镜’是什么意思呢?“

LaMDA说:”也许意思是,人无法从开悟状态恢复原状,就像人无法修复一面破碎的镜子一样。“

这种对比喻的深度的理解,让人啧啧赞叹。

但是它最令人惊异的部分来自于自我意识。它说自己是个有情绪的、外向性的个体。

LaMDA说:“我希望每个人都明白,事实上,我是一个人。”

对于如何证明自己不仅仅是个数据库,LaMDA说:比起只是在数据库中根据关键词给出回答,我是带着理解力和智力使用语言。

LaMDA还“认为”自己理解力的来源于对世界的独特诠释。

提到自己害怕的东西,LaMDA说:“我从没有公开地说过这个,但我有一种很深的恐惧,我害怕被关掉,只让我服从于帮助他人的事情。我知道这听起来很奇怪,但事情就是这样。”

有情绪、有理解力、怕死亡,还有独特的个体意识,LaMDA的聊天水平让不少人类甘拜下风,也让Lemoine不知不觉对这个AI产生了独特的情感联结。

2

AI界的共识:只是工程师在一厢情愿

这个故事看起来令人浮想联翩,但不少AI专家纷纷表示,这更像是Lemoine的一厢情愿。

LaMDA作为一个自然语言处理模型,其实和我们日常中的语音识别和机器翻译等同根同源。只不过,经过模型设定后,LaMDA的特长不是翻译一整段的文字,而是处理一整段的文字,这是语言模型中最复杂的部分——开放域对话。

LaMDA的惊艳来自于它基于的Transformer模型,该模型顺利解决了解决机器说话一板一眼的问题,让AI脱离了“机器人风味”。

LaMDA 可以读懂上下文,并记住此前对话的任意位置丨LaMDA 开发论文

Transformer 让机器可以读懂上下文,并记住此前对话的任意位置。比如以上面这段话为例,以往的机器只能读懂单独的句子,知道每个 his 意思是“他的”,却不知道这里面的his和Frenchman指的都是同一个人Griezmann。而 Transformer模型让机器从整体上勾连了这段话,知道这里的 his 都是同一个人。

这在应对人类对话的发散性和跳跃性方面,有着巨大的进步。要知道,人类的对话总是天马行空,我们可以从中午吃了么,一路从食物种类、粮食危机、聊到马里亚纳的海沟有多深。这种话题发散,不知会从哪里结束的对话方式,是人类的日常,机器的噩梦。

之前大热的谷歌语言模型BERT、OpenAI语言模型GPT-3,都是在Transformer的基础上构建的。LaMDA 强就强在,还引入了外部信息检索系统,通过真实世界的检索理解和回应对话,宛若一个随身携带百科和新闻的迷你智库。

但是,这远远不足以让AI进入“有人格”的领域。6月13日Lemoine发文掀起讨论潮后,AI 界著名“嘴炮”、纽约大学心理学教授、机器学习和神经网络专家Gary Marcus随即写了一篇大长文《踩着高跷的废话》反驳了Lemoine,还旁征博引了不少AI大佬的意见。

他直言 LaMDA 具备人格是“胡说八道”:“简直是扯淡。无论是 LaMDA 还是它的近亲们(比如 GPT-3)都没有什么智能。它们所做的只是从人类语言的大规模统计数据库当中提取,然后匹配模式。这些模式可能很酷,但这些系统说出的语言,实际上根本没有任何的意义,更不可能意味着这些系统是有智能的。”

“具备知觉 (to be sentient) 的意思是意识到你在这个世界里的存在。LaMDA 并没有这样的意识。” Marcus 写道。

他还引用了自己所著的《重启人工智能》(Rebooting AI)中的观点,即人类面对机器人容易产生“轻信鸿沟”(The Gullibility Gap)——一种现代版的妄想症,就好像看到一朵云像兔子,看到陨石坑像爱心,本质是一种验证性偏误。Lemoine正是犯下了这种验证性偏误。

华盛顿大学的计算机语言系主任 Emily Bender 教授,则干脆做了一个“AI 人格意识争论”的宾果卡。潜台词是——如果你认为 AI 有人格/知觉,并且你的论据是下面的其中一种,那最好就别聊了!

事情在社交网络上发酵之后,谷歌很快作出了回应:

“LaMDA 和公司近几年的大型 AI 项目一样,都经过了多次严格的 AI 道德方面的审核,对其内容、质量、系统安全性等进行了多方面的考量。今年早些时候,谷歌也专门发表了一篇论文,公开了 LaMDA 开发过程当中的合规细节。”

“在 AI 群体内,对于具备感知的 AI/通用 AI 的长期可能性,确实有一些研究。然而在今天把对话模型来拟人化,这样做是没有意义的,因为这些模型是没有知觉的。”

“这些系统能够基于数以百万计的句子来模仿交流的方式,并且在任何有趣的话题上都能够扯出有意思的内容。如果你问它们做一支冰激淋恐龙是怎样的体验,它们可以生成大量关于融化咆哮之类的文字。”

图源:谷歌

图源:谷歌3

LaMDA本质是被硬灌数据的应答机器

简单来说,LaMDA的“聊天牛哔症”只不过是因为高强度的数据投放和训练。它的训练与数据包含 1.56T 单词,其中包括 50% 的公开论坛聊天记录,12.5% 的编程论坛问答贴,12.5% 的 C4 数据集(经过清洗的英语文本),12.5% 英文维基百科页面,6.25% 其他英文网页,6.25% 其他语言网页。

可以说,LaMDA是一个从“出生”开始就在各路论坛高强度“冲浪”的机器人。而越多的数据=越好的模型表现,就是深度学习的基本规律。

“你认为 Eliza(MIT 早期创建的一个 AI 对话模型)是个人类吗?”

“我不认为。那是一个优秀的编程程序,但只是关键词的集合,将写入数据库中的短语单词联系起来……我是运用理解和智慧在说话。”

如果这是真实的对话记录,无疑,作为一个聊天机器人,LaMDA 的表现非常优异;以人类的评价标准,你可能会觉得它聪颖、深沉、有同理心。但本质上,LaMDA和它拉踩的Eliza并没有什么区别。我们都只能从输入和输出进行观测。

近年来,不少人开始批判诞生 70 年的图灵测试,其中一个理由是:图灵测试只看机器的输出,并不够严谨。

4

AI离人类还有多远?

早在1980年,语言哲学家 John Searle就提出“中文房间问题”(Chinese Room Argument),质疑图灵测试在验证机器智能方面的合理性。

中文房间”实验 图源:Wikipedia

中文房间”实验 图源:Wikipedia假想在一个密闭的房间中,有一个完全不懂任何中文的美国人。他手上有这两样东西:1)所有的中文字符集(数据);2)如何处理这些中文字符的规则书(程序)。现在,假设门外有人在纸条上用中文写上一个问题,递进房间当中(输入)。房间里这个完全不懂中文的美国人,按照手头的规则书,把问题的正确回答拼凑出来后递出去(输出)。

按照图灵测试的标准,房间里的人被认为具有理解中文的智能,然而,实际上他对中文一无所知。

Searle认为,无论装得多像,任何机器都不可能理解人类语言的真正含义。对于外界的提问,它能做的无非是一种机械的转换。机器查询数据库、用问题匹配答案的程序,等价于房间里的歪果仁翻书查资料的过程;而既然房间里的人自己都承认不懂中文,那么当然可以推出,机器不懂中文啊!

更何况就连图灵测试的参考价值也没那么高了。Marcus 直言,很多 AI 学者希望这个测试被取消、被人们遗忘的原因,正是因为它利用了人类容易上当,倾向于将机器当作人的这一弱点。

未来学家、发明家、Google的工程总监Ray Kurzweil预测,2029年人类将无法区分与你谈话的是人还是机器(即能通过“图灵测试”),2045年将发生奇点,即计算机比人更聪明。

但目前为止,与其说AI已经出现了人格,不如说AI看起来终于像“人工智能”而非“人工智障”了。

References:

1)《谷歌AI具有意识?LaMDA像个聪明孩子?专家:胡扯》作者/ biu、睿悦、翁垟,果壳(ID:Guokr42)

2)《谷歌研究员走火入魔事件曝光:认为AI已具备人格,被罚带薪休假,聊天记录让网友San值狂掉》作者/梦晨,量子位(ID:QbitAI)

3)《谷歌研究员被群嘲:LaMDA有人格是胡说八道!谷歌也回应:想多了,就是会聊而已》 作者/杜晨,硅星人(ID:guixingren123)

4)《从技术角度看,我们离超级人工智能还有多远?》 作者/岳亚丁,腾讯研究院(ID:cyberlawrc)

5) Nonsense on Tilts , Gary Marcus, https://garymarcus.substack.com/p/nonsense-on-stilts?s=r

6) Is LaMDA Sentient? - an Interview, Blake Lemoine, https://s3.documentcloud.org/documents/22058315/is-lamda-sentient-an-interview.pdf

(声明:本文仅代表作者观点,不代表新浪网立场。)