GPT-3数学不及格,愁坏伯克利团队,于是他们出了12500道数学作业

来源:量子位

贾浩楠 发自 凹非寺

量子位 报道 | 公众号 QbitAI

GPT-3,是个严重偏科的“文科生”。

UC伯克利的研究人员,在对类似GPT-3的大型语言模型进行测试后发现,数学,就是这类AI的盲区。

12500道高中数学题,GPT-3的正确率最低不到3%,最高也没超过7%。

完全不合格啊~

一直以“全知全能”形象示人的GPT-3,在面对数学问题时却一脸懵逼,这怎么能行?

于是,伯克利的团队,就量身为大语言模型打造了一个数学问题数据集。

“文科生”的数学作业,终究还是逃不掉。

为啥要让AI学数学?

AI学了数学有啥用?

数学是所有科学的基础,模拟行星轨道、原子运动、棋牌游戏等等本质都是数学问题。

去年大火的AlphaFold,生成预测蛋白质结构,本质也是复杂数学问题求解。

此外,AI解数学题时对不同解题方法的选择组合,也是衡量算法能力的参考。

所以,即便GPT-3平时面对的多是文本任务,但让它去学数学,依然有助于人们弄明白超大模型处理数学推理任务的特点。

之前的研究已经证明,牢固掌握数学概念对AI很重要。

例如,OpenAI最近推出了GPT-f,这是Metamath形式化语言的自动证明器和证明助手。

GPT-f对一些数学问题做出的证明,已经被Metamath主库所接受,这是AI的数学论证第一次数学社区所采用。

Facebook方面也声称已经成功实验了数学AI算法。在去年1月的一篇博客文章中,该公司的研究人员表示,他们已经教会了一个模型将复杂的数学方程视为一种语言,然后将解题过程视为翻译问题。

鉴于此,伯克利的团队创建了数学问题数据集MATH,其中包括12500道来自高中数学竞赛的习题。

果然,AI现在也躲不过数学竞赛了。

MATH能起到什么用?

MATH的12500道数学题,来自包括 AMC10、AMC12、AIME 等等竞赛。其中许多问题是从 aops社区收集的。

这些竞赛题跨越了几十年历史,主要目的是评估数学人才的问题解决能力。

所以,MATH与之前所有类似数学数据集不同,大多数问题不能通过简单地应用标准K-12数学工具来解决。

无论是人还是AI,必须通过活用数学知识和“启发式”的推理手段才能得到答案。

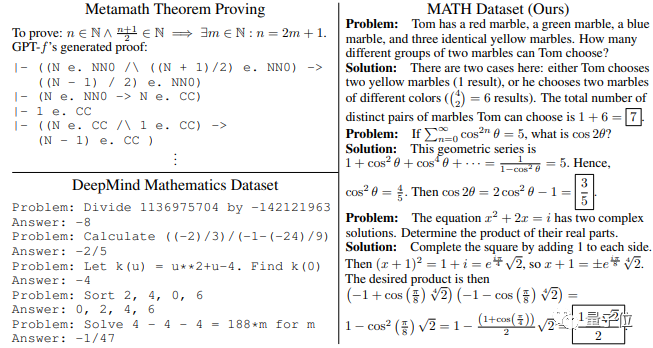

△

△不同数据集中数学问题对比

12500个问题中,包括7500个训练问题,和5000个测试问题。

其中的范围,包括代数、微积分、统计、几何、线性代数、数论等等。

在每个子领域下,相关问题涉及几乎所有重要定理和公式.

比如多项式展开、三角形面积、幂级数展开…..

而MATH与以往所有数学数据集最大的不同,就是它的每一个训练问题下,都有清晰的解题步骤和公式依据。

训练后的模型,可以学习到许多有用的启发式解决问题的思路。

除了MATH,团队还推出了一个庞大而多样化的数学预训练语料库AMPS。

AMPS的Khan子集有693个练习类型,超过100,000个问题,基本上是K-12教学中常用的。问题类型从初级数学(如加法)到多变量微积分(如斯托克斯定理),并用于教授实际的K-12学生.

团队还贡献了自己的Mathematica脚本,生成了约500万个的问题。

这个超过23GB大小的数据集,是专门用来训练超大模型用的。其中的问题包括代数、微积分、计数和统计学、几何学、线性代数和数论的各个方面。

与之前的算法生成数学问题的方法不同,由于使用了Mathematica的计算机代数系统,这样使用者就可以直接对分数、分析函数等等进行操作。

AI的数学,及格了吗?

尽管是高中竞赛题,但难度依然不小。

团队特地用MATH对人类进行了评估,结果,一名计算机科学博士学生的答题正确率为40%。

一位三次获得IMO金牌的人成功率达到了90%,这表明MATH对人类也具有挑战性.

而在对AI进行训练测试后,发现成绩依然不理想。

数据集中的分步解决方案,能让语言模型像人类数学家一样使用 “短期记忆”。

即模型不必马上得出正确答案,而是可以逐步探索解法一步步走向正确答案。

但即使有了解决方案,研究者发现,对于GPT-2和GPT-3来说,准确率仍然很低.

从上图结果中能看出,让模型在产生答案之前生成自己的解决方案,实际上降低了准确性。因为在许多错误案例中,尽管解题步骤与问题相关,但它们是不合逻辑的。

此外,简单地增加模型中的训练时间和参数数量,有时会提高性能。但事实证明,这样做的代价过于高,训练的时间和能耗都大大增加。

而在AMPS上进行预训练可将准确率提升约25%,这相当于将模型大小提高15倍。

所以,尽管恶补了12500道高中数学竞赛题,GPT-3还是不及格。

但研究人员认为,让AI学会分步解题仍然有进步意义。

与直接在问题和答案上进行训练相比,MATH上训练过的模型,可以提高10%的相对准确率。

最重要的,是模型“掌握”了一些基本数学知识。在一些错误的解法下,AI已经懂得调用相关的公式定理,而不是胡言乱语一通。

AI数学竞赛的第一课,并不是毫无收获。

GPT-3也不要灰心,伯克利的团队说了,随着对模型的改进,今后它们的数学推理能力会越来越强。

MATH和AMPS现在都已开源,有兴趣的研究者可以直接下载:

https://github.com/hendrycks/math/

(声明:本文仅代表作者观点,不代表新浪网立场。)