亚马逊AIGC全家桶推出!迎战微软谷歌,云巨头们杀疯了

亚马逊打响对战微软OpenAI联盟的第一枪!

作者 | 智东西李水青

编辑 | 心缘

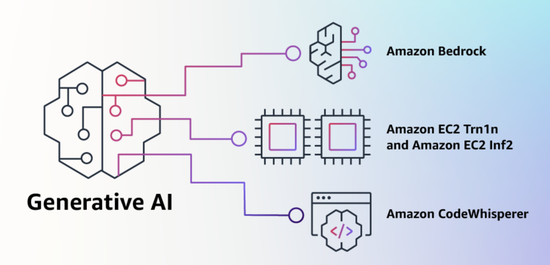

智东西4月14日报道,当地时间4月13日,全球第一大云巨头AWS推出生成式AI(AIGC)工具“全家桶”,重磅空降ChatGPT引发的全球AI大竞赛战场!

与微软、谷歌从消费级产品切入的做法不同,亚马逊旗下的AWS精准狙击企业用户,且产品覆盖IaaS实例、PaaS平台、SaaS软件全栈技术层。

至此,国外公有云巨头AWS、微软Azure、谷歌云,国内的阿里云、百度智能云已悉数参团AIGC大战,仍有华为云、腾讯云等云大厂有待进一步动作。AWS的重拳出击让其他云厂商不得不更快采取措施。

首先,AWS推出生成式AI平台Bedrock服务,支持用户通过API访问亚马逊自己的Titan(泰坦)大模型,是由今天推出的两个全新大语言模型组成;同时支持调用来自AI21 Labs、Anthropic、Stability AI等第三方的多样化模型。目前,OpenAI开放了ChatGPT的API,但微软、谷歌并未推出类似的PaaS开放平台。

同时,Bedrock一个核心特征是支持企业自定义基础模型,只需少量数据就完成模型定制化和微调。在这一方面上,国内百度文心一言、阿里云通义千问也推出了类似的企业级服务。

然后,AWS推出了两款专门针对生成式AI优化的计算实例EC2 Trn1n实例和EC2 Inf2。训练实例EC2 Trn1由其自研芯片Trainium支持,可节省高达50%的训练成本,EC2 Trn1n更进一步性能再提高20%;推理实例Inf2基于其自研芯片Inferentia2,据称吞吐量提高了4倍,延迟降低了10倍。AWS应该是云巨头中首个推出专门面向生成式AI实例的玩家。

最后,AWS预见生成式AI的使用将快速增长的一个领域是编程,为此推出一款AI编程伴侣:CodeWhisperer,可辅助程序员编程,据称促进用户执行任务速度提升57%,CodeWhisperer预览版将面向所有用户免费开放。这一产品于微软旗下GitHub上线的基于GPT-4的CopilotX平台类似,但AWS称其首创了内置安全扫描,能查找难以检测的漏洞并提出补救建议。

亚马逊CEO安迪·贾西(Andy Jassy)周四发布2022年度股东信称:“我可以为LLM(大语言模型)和生成式AI专门写一封信,因为我认为它们将具有革命性,对我们的客户、股东和亚马逊来说将是一件大事。”

这封信随之而至,AWS在今早关于生成式AI的公告中提到:“ChatGPT是第一个引起客户注意的生成AI,但大多数研究者很快意识到技术潜力,有几种不同的FM(基础大模型)可供使用,每一种都具有独特的优势和特征,我们期待未来会出现新的架构,FM的多样性将掀起一波创新浪潮。”

01.

上线AIGC平台,提供自研LLM和第三方模型,支持企业定制

生成式AI是一种可以创造新内容和想法的AI,包括对话、故事、图像、视频和音乐。与所有AI一样,生成式AI由机器学习模型提供支持,这些模型是基于大量数据进行预训练的超大模型,通常称为基础大模型(FM)。

AWS收到了不少客户的反馈他们遇到的困扰,包括:

1、他们需要一种能更直接简单调用的效果好、契合需求的高性能FM。

2、他们希望无缝集成到应用程序中,不必管理庞大的基础设施集群或产生大量成本。

3、他们希望在轻松获取基础FM的同时,使用自己本地数据构建定制化应用程序。

4、数据资产被保护,保障安全和私密,能控制数据共享和使用方式。

为此,AWS今天宣布推出Amazon Bedrock新服务,可以通过API访问来自AI21 Labs、Anthropic、Stability AI和亚马逊自己的基础大模型。

AWS称,Bedrock是用户使用FM构建和扩展基于AI的生成应用程序的最简单方法,将提供访问一系列强大文本和图像大模型能力——包括亚马逊的Titan FM,它由AWS今天也宣布的两个新的LLM组成。

借助Bedrock的Serverless(无服务器)体验,客户可以轻松地找到适合他们要完成的工作的正确模型、快速入门、使用他们自己的数据私下定制FM,并使用AWS工具和功能将它们集成并部署到应用程序中。比如用户可以将Bedrock与Amazon SageMaker ML功能集成,例如用于测试不同模型的实验和用于大规模管理其FM,而无需管理任何基础设施。

Bedrock客户可以从当今可用的最前沿FM中进行选择。这包括来自AI21 Labs的Jurassic-2系列多语言LLM,它们遵循自然语言指令生成西班牙语、法语、德语、葡萄牙语、意大利语和荷兰语的文本;Bedrock还可以轻松访问Stability AI的文本到图像基础模型套件,包括Stable Diffusion,它能够生成独特、逼真、高质量的图像、艺术、徽标和设计等。

▲Stable Diffusion应用界面

Bedrock最重要的功能之一是定制模型非常容易。客户只需Bedrock指向Amazon S3实例中的几个标记示例,该服务就可以针对特定任务微调模型,而无需注释大量数据(少至20个示例就足够了)。

想象一下,一位内容营销经理在一家领先的时装零售商工作,他需要为即将推出的新手袋系列制作新的、有针对性的广告和活动文案。为此,他们向Bedrock提供了一些带标签的示例,这些示例展示了过去营销活动中表现最好的标语,以及相关的产品描述,Bedrock将自动开始为新手袋生成有效的社交媒体、展示广告和网络副本。并且,没有客户的数据被用来训练底层模型。

Bedrock正面向部分客户推出预览版。美国办公协作服务商Coda的联合创始人兼首席执行官Shishir Mehrotra(西什尔·梅罗特拉)说:“作为AWS的长期满意客户,我们对Amazon Bedrock如何为Coda AI带来质量、可扩展性和性能感到兴奋。由于我们的所有数据都已在AWS上,因此我们能够使用Bedrock快速整合生成式AI,并具有保护我们的内置数据所需的所有安全性和隐私性。有超过数万个团队在Coda上运行,包括Uber、纽约时报和Square等大型团队,可靠性和可扩展性非常重要。”

AWS一直在与一些客户测试其新的Titan FM,计划未来几个月推广,其最初会有两个Titan模型。

第一个是生成式LLM(generative LLM),用于诸如摘要、文本生成、分类、开放式问答和信息提取等任务。

第二种是嵌入式LLM(embeddings LLM),它将文本输入翻译成包含文本语义的数字表示。虽然此LLM不会生成文本,但它对于个性化和搜索等应用程序很有用,因为通过比较嵌入,模型将产生比单词匹配更相关和上下文相关的响应。事实上,亚马逊电商平台的产品搜索功能使用了类似的嵌入模型来帮助客户找到他们正在寻找的产品。

02.

推出AIGC基础设施:基于自研芯片上线EC2 Trn1n、Inf2实例

AWS宣布推出由AWS Trainium提供支持的Amazon EC2 Trn1n实例和由AWS Inferentia2提供支持的Amazon EC2 Inf2实例,据称这是用于生成AI的最具成本效益的云基础设施。

由Trainium提供支持的Trn1实例可以比任何其他EC2实例节省高达50%的训练成本,并且经过优化以在与800 Gbps第二代Elastic Fabric Adapter(EFA)网络连接的多台服务器之间分发训练。客户可以在UltraClusters中部署Trn1实例,这些实例可以扩展到位于同一AWS可用区中的30000个Trainium芯片(超过6ExaFLOPS的计算),具有PB级网络。许多AWS客户,包括Helixon、Money Forward 和 Amazon Search团队,都使用Trn1实例来帮助将训练最大规模深度学习模型所需的时间从几个月缩短到几周甚至几天,同时降低成本。

800 Gbps是一个很大的带宽,但AWS称自己不断创新以提供更多带宽,今天宣布新的网络优化Trn1n实例的普遍可用性,它提供1600 Gbps的网络带宽,旨在为大型网络密集型模型提供比Trn1高20%的性能。

亚马逊CEO安迪·贾西(Andy Jassy)说:“对于最常见的机器学习模型,基于Trainium(AWS自研AI训练芯片)的实例比基于GPU的实例快140%,而成本最多降低70%。”

AWS称,今天,花在FM上的大部分时间和金钱都用于培训他们,这是因为许多客户才刚刚开始将FM部署到生产中。但是,在未来大规模部署FM时,大部分成本将与运行模型和进行推理相关。Alexa是一个很好的例子,每分钟有数百万个请求,占所有计算成本的40%。因此AWS在几年前开始投资新芯片时优先考虑推理优化的芯片。

2018 年,AWS发布了首款推理专用芯片Inferentia,现在生成AI增加了工作负载的规模和复杂性,这是AWS今天宣布由AWS Inferentia2提供支持的Inf2实例全面上市的原因。

Inferentia2专门针对包含数千亿个参数的模型的大规模生成人工智能应用进行了优化。与上一代基于Inferentia的实例相比,Inf2实例的吞吐量提高了4倍,延迟降低了10倍。

它们还具有加速器之间的超高速连接,以支持大规模分布式推理。与其他类似的Amazon EC2实例相比,这些功能可将推理价格性能提高多达40%,并使云中的推理成本最低。对于某些模型,像Runway这样的客户发现Inf2的吞吐量比同类Amazon EC2实例高出2倍。这种高性能、低成本的推理将使 Runway能够引入更多功能,部署更复杂的模型。

03.

上线AI编程伴侣CodeWhisperer对个人开发者免费开放

AWS预见生成式AI的使用将快速增长的一个领域是编程。

今天的软件开发人员花费大量时间编写非常简单且无差别的代码,还花费大量时间试图跟上复杂且不断变化的工具和技术环境,没有时间开发新的、创新的功能和服务。生成式AI可以通过“编写”大量无差异代码来消除这种繁重的工作。

为此,AWS宣布推出Amazon CodeWhisperer的预览版,一种AI编程伴侣,它基于FM,根据开发人员的自然语言评论和集成开发环境(IDE)中的先前代码实时生成代码建议,提高开发人员的工作效率。

开发人员可以简单地告诉CodeWhisperer执行一项任务,例如“解析CSV歌曲字符串”,并要求它返回一个基于艺术家、标题和最高排行榜排名等值的结构化列表。CodeWhisperer通过生成解析字符串并返回指定列表的完整函数来提高工作效率。

在预览版试用期间,AWS进行了一项生产力挑战,使用CodeWhisperer的参与者平均比不使用CodeWhisperer的参与者完成任务的速度快57%,成功完成任务的可能性高27%,AWS称这是开发人员生产力的巨大飞跃。

AWS宣布适用于Python、Java、JavaScript、TypeScript和C#的Amazon CodeWhisperer以及十种新语言(包括Go、Kotlin、Rust、PHP和SQL)全面上市。

AWS补充称,CodeWhisperer是唯一具有内置安全扫描(由自动推理提供支持)的AI编码伴侣,用于查找难以检测的漏洞并提出补救建议,例如十大开放式全球应用程序安全项目(OWASP)中的漏洞,那些不符合加密库最佳实践等。CodeWhisperer过滤掉可能被认为有偏见或不公平的代码建议,并且CodeWhisperer是唯一可以过滤和标记类似于客户可能希望参考或许可使用的开源代码的代码建议的编码伴侣。

CodeWhisperer对所有没有个人用户免费生成代码,任何人都可以只用一个电子邮件帐户注册CodeWhisperer,并在几分钟内提高工作效率,甚至不必拥有AWS账户。对于企业用户AWS提供了一个CodeWhisperer Professional Tier,其中包括单点登录(SSO)与 AWS Identity and Access Management (IAM)集成等管理功能,以及更高的安全扫描限制。

04.

结语:对战微软谷歌亚马逊如何后发制人?

随着AWS参战,美国三大公有云服务巨头亚马逊、微软、谷歌都已将生成式AI置于营销宣传的中心,试图利用人们对这一技术兴趣的爆发式增长,开辟新战场的同时促进增长疲软的云业务回暖。

作为后发的云大厂,AWS开辟了不同道路,相比谷歌等避免了对AI公司及消费级产品的重大投资,而是建立平台汇聚众多中小企业的模型。基于众多云客户业务和数据放在AWS的优势,其有望用此策略后发制人。在国内,阿里云、百度智能云等云大厂也都已经行动,腾讯云、华为云还未正式出击,国外云大厂的策略为国内玩家提供了参考。

(声明:本文仅代表作者观点,不代表新浪网立场。)