安装新浪财经客户端第一时间接收最全面的市场资讯→【下载地址】

专题:OpenAI 发布最新旗舰模型GPT-4o 完全免费 语音功能震撼登场

来源:硬AI

虽然没有带来备受期待的人工智能(AI)搜索引擎,但OpenAI在主打产品AI模型上花了更多心思,拓展多模态功能,让用户可以免费玩转文字、图片和语音输入。

美东时间5月13日周一,OpenAI首席技术官Mira Murati在直播演示中宣布,推出新的OpenAI旗舰AI模型,名为GPT-4o,称它面向所有人,包括免费用户,为“我们的免费用户带来GPT-4级的智能”。OpenAI还推出了台式机版本的ChatGPT以及新的用户界面(UI)。

Murati说:“这是我们第一次在便于使用方面真正迈出一大步。” 她评价,GPT-4o的“速度快得多”,提升了GPT-4在文本、视频和音频方面的功能,“GPT-4o 通过语音、文本和视觉进行推理”。

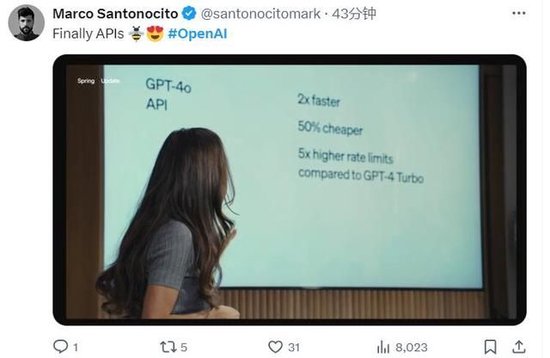

Murati在演示中称,相比GPT-4 Turbo,GPT-4o的速度快了两倍,成本降低了50%,API速率限制、即用户可发出的请求数量提高了五倍。有网友在社交媒体X上对此感到开心,称API终于改进了。

实时求解方程、做口译、分析图表、读取用户情绪

GPT-4之前已经可以分析图像和文本,完成从图像中提取文本、以文本描述图像内容这类任务。GPT-4o则是增加了语音功能。Murati 强调了GPT-4o在实时语音和音频功能方面必要的安全性,称OpenAI将继续部署迭代,带来所有的功能。

在演示中,OpenAI 研究主管 Mark Chen掏出手机打开ChatGPT,用语音模式Voice Mode现场演示,向GPT-4o支持的ChatGPT征询建议。GPT的声音听起来像一位美国女性,当它听到Chen过度呼气时,它似乎从中察觉到了他的紧张。 然后说“Mark,你不是吸尘器”,告诉Chen要放松呼吸。如果有些大变化,用户可以中断GPT, GPT-4o的延迟通常应该不会超过两三秒。

另一项演示中,OpenAI的后训练团队负责人Barret Zoph在白板上写了一个方程式3x+1=4,ChatGPT给他提示,引导他完成每一步解答,识别他的书写结果,帮助他解出了X的值。这个过程中,GPT充当了实时的数学老师。GPT能够识别数学符号,甚至是一个心形。

应社交媒体X的用户请求,Murati现场对ChatGPT说起了意大利语。GPT则将她的话翻译成英语,转告Zoph和Chen。听完Murati说的意大利语,GPT翻译为英文告诉Chen:“Mark,她(Murati)想知道鲸鱼会不会说话,它们会告诉我们什么?”

OpenAI 称,GPT-4o还可以检测人的情绪。在演示中,Zoph将手机举到自己面前正对着脸,要求ChatGPT告诉他自己长什么样子。最初,GPT参考了他之前分享的一张照片,将他识别为“木质表面”。经过第二次尝试,GPT给出了更好的答案。

GPT注意到了Zoph脸上的微笑,对他说:“看起来你感觉非常快乐,喜笑颜开。”

有评论称,这个演示显示,ChatGPT可以读取人类的情绪,但读取还有一点困难。

OpenAI的高管表示,GPT-4o可以与代码库交互,并展示了它根据一些数据分析图表,根据看到的内容对一张全球气温图得出一些结论。

OpenAI称,基于GPT-4o的ChatGPT文本和图像输入功能将于本周一上线,语音和视频选项将在未来几周内推出。

X平台的网友注意到了OpenAI展示的新功能。有网友指出,GPT-4o不仅可以将语音转换为文本,还可以理解和标记音频的其他特征,例如呼吸和情感,不确定这在模型响应中是如何表达的。

有网友指出,根据演示,ChatGPT的语音能帮助实时求解方程,像人类一样说话,而且几乎是即时响应,全部都在手机上运行。

最快232毫秒响应音频输入 平均响应时间和人类相似

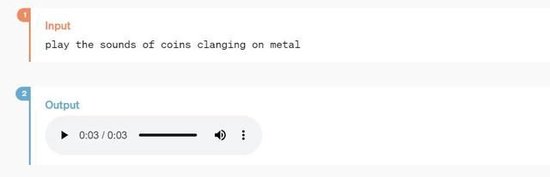

OpenAI官网介绍,GPT-4o中的o代表意为全能的前缀omni,称它向更自然的人机交互迈进了一步,因为它接受文本、音频和图像的任意组合作为输入内容,并生成文本、音频和图像的任意组合输出内容。

除了API的速度更快、成本大幅下降,OpenAI还提到,GPT-4o可以在最快232毫秒的时间内响应音频输入,平均响应时间为320毫秒,这与人类在对话中的响应时间相似。它在英语文本和代码方面的性能与GPT-4 Turbo 的性能一致,并且在非英语文本方面的性能有了显著提高。

OpenAI介绍,与现有模型相比,GPT-4o 在视觉和音频理解方面尤其出色。以前GPT-3.5和GPT-4用户以语音模式Voice Mode与ChatGPT 对话的平均延迟时间为2.8 秒和 5.4 秒,因为OpenAI用了三个独立的模型实现这类对话:一个模型将音频转录为文本,一个模型接收并输出文本,再有一个模型将该文本转换回音频。这个过程意味着,GPT丢失了大量信息,它无法直接观察音调、多个说话者或背景噪音,也无法输出笑声、歌唱或表达情感。

而GPT-4o的语音对话是OpenAI跨文本、视觉和音频端到端训练一个新模型的产物,这意味着所有输入和输出都由同一神经网络处理。OpenAI称,GPT-4o 是其第一个结合所有这些模式的模型,因此仍然只是浅尝辄止地探索该模型的功能及其局限性。

上周曾有消息称,OpenAI将发布基于AI的搜索产品,但上周五OpenAI的CEO Sam Altman否认了该消息,称本周一演示的既不是GPT-5,也不是搜索引擎。这意味着OpenAI再一次没有像市场爆料的时间线那样推出AI搜索。此后有媒体称,OpenAI的新产品可能是一个具备视觉和听觉功能的全新多模态AI模型,且具有比目前聊天机器人更好的逻辑推理能力。

本周一的演示的确展示了OpenAI在语音方面的努力。对于OpenAI推出的新模型和UI更新,有网友称,感觉到目前为止OpenAI没有那么开创性。

也有网友觉得OpenAI进一步拉开了和苹果的差距,还发了一张人满头大汗的动图,称现在苹果的语音助手Siri应该是这个样子。

责任编辑:欧阳名军

VIP课程推荐

APP专享直播

热门推荐

收起

24小时滚动播报最新的财经资讯和视频,更多粉丝福利扫描二维码关注(sinafinance)