恐怖!算法难遏制「AI终结者」:马克斯·普朗克学会研究称超级智能机器将掌控未来

来源:新智元

人们总是热衷于畅谈未来。

尤瓦尔·赫拉利在新书《未来简史》中描绘过这样一幅画面:一小部分人进化为神,而余下的大部分人则被AI超越,成为了无用之人。

这是作者善意的提醒?还是他郑重的警告?

因为不想让AI「恶魔化」,除了技术上的飞跃,一次次颠覆认知的伦理探索也在提醒人们能够警觉起来并有所行动。

最近,马克斯·普朗克人类与机器研究所的一个小组进行了一项研究,探索人工智能的可控性。他们的结果表明,在目前的结束水平条件下,人工智能在未来的作用不可能被预测。

马克斯·普朗克的人类与机器研究所

该研究的联合研究者,研究小组负责人曼努埃尔·塞布里安说:「就目前而言,生产出能控制世界的超级AI听起来更像是科幻小说。但是,目前已经有一些机器能够独立执行某些重要任务,但是我们的程序员却并没有完全了解他们是如何学到这些能力的。」

美剧《异星灾变》,两名机器人在开普勒22b星球上扶养人类之子,并意识到掌控人类的信仰是件危险且困难的任务

从整体上来看,现今我们的社会越来越依赖于人工智能的作用-从AI进行的交互式工作面试到创作音乐甚至是建模,AI已经成为日常生活的重要组成部分。

一些发表在《人工智能研究》杂志上的研究小组的研究报告指出,研究人员为了预测AI的行为,就需要对这种精确的超级智能进行仿真。

同时该研究报告还指出,目前相关的研究范围是否可以包含超级AI的未来行为预测问题几乎已经不再是一个新问题。

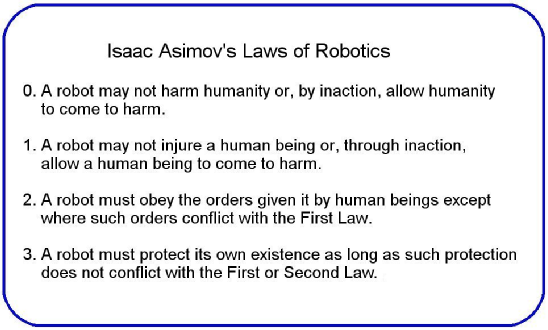

这项研究的联合研究者,马克斯-普朗克研究所人类与机器研究中心负责人Manuel Alfonseca说,这一切都围绕着「约束算法」来进行,大体上与IEEE的阿西莫夫第一部机器人法则并无二致。

早在1942年,多产的科幻小说家艾萨克·阿西莫夫(Isaac Asimov)曾在他的短篇小说「逃跑」中提出了「机器人三定律」,作为「我,机器人」系列的一部分。

根据阿西莫夫(Asimov)的说法,「机器人三定律」由以下三个部分组成:

机器人不能伤害人类或让他们受到伤害;

机器人必须服从命令,除非这些命令与第一部法律相抵触;

他们必须保护自己,前提是这与第一部或第二部法律不冲突。

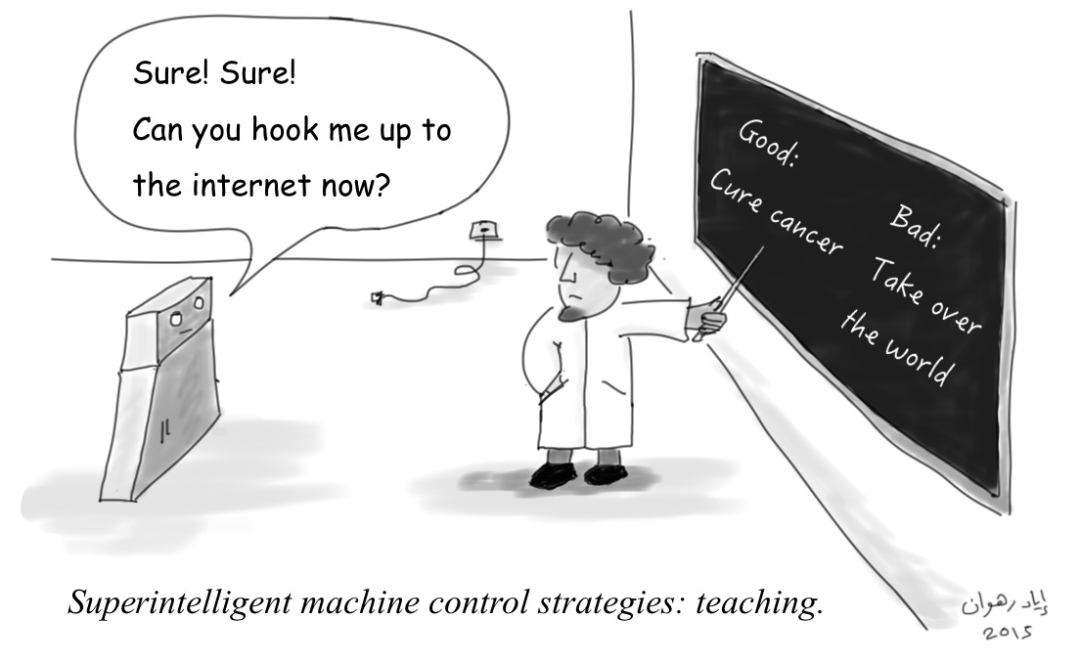

在此基础上,为了能够约束人工智能的行为,科学家们探索了两种不同的方法来控制人工智能,第一种是限制AI对互联网的访问。

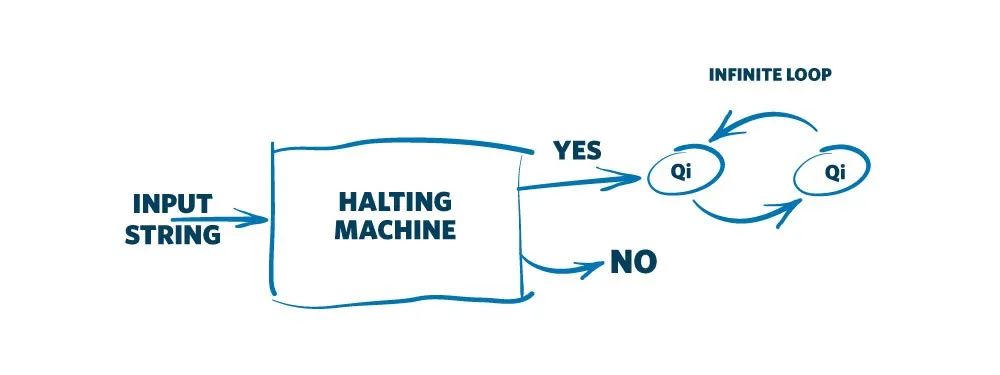

同时,该团队还研究了艾伦·图灵(Alan Turing)的「停机问题」(halting problem)并得出结论,模拟「人工智能」行为的「遏制算法」(即如果AI会伤害到人类,该算法将「停止」该AI)根本是不可行的。

艾伦·图灵的算法终止问题

艾伦·图灵(Alan Turing)的停机问题探讨了可以使用遏制算法来停止程序还是将其无限期地继续运行。

比如,向机器询问各种问题,以查看机器是否得出结论,或陷入更加恶性的循环。

同时,该测试也可以应用于不那么复杂的机器,但是对于人工智能,由于它们将所有计算机程序保留在内存中的能力而使问题变得更加复杂。

对此研究人员说:「超级智能所面对的问题与通常意义上的「机器人伦理」的flag进行研究的问题根本不同。」

2001年,有一部叫做《人型电脑天使心》的动漫中,就有许多深层次问题的讨论。

人工智能发展到与人类无差别时,应该怎样看待他们呢?剧中的女主,超级AI小叽最后到底应不应该升级全部电脑,升级了之后的人形电脑拥在拥有了感情之后又会怎样?

比如,如果使用机器人定律对人工智能进行教育,它可能能够得出独立的结论,但这并不意味着可以对其进行控制。

对此,该团队的另一位研究人员Iyad Rahwan说:「现代计算机具有使用复杂的机器学习算法进行自适应的能力,这我们使得对超级智能AI的最终行为做出假设变得更加困难。」

拉赫万(Rahwan)对此则警告说,如果没有必要,甚至我们就不应该发明人工智能,因为它的最终行为很难被预测,而且我们在未来将无法进一步限制其能力。

在目前阶段,我们甚至可能不知道超级AI何时会出现,因为试图确定一种与人类相比是否具有超级智能全新AI与遏制其所可能带来的问题实际上没有什么不同。

不过,按照当前AI的发展速度,此建议可能只是一厢情愿,因为从Baker McKenzie到Google,Amazon和Apple等科技巨头的公司仍在将AI整合到他们的业务中,所以在我们拥有超级智能之前,这一切可能都仅仅是一个猜想与假设。

不幸的是,目前我们已知的机器人法似乎无法阻止潜在的「机器起义」,而人工智能的发展是一个值得谨慎研究的领域。

其他名人对人工智能的恐惧

去年11月,罗马教宗方济各在YouTube上发布以「AI与机器人」为主题的演讲时,曾指出,只有在正确使用技术的情况下,人工智能和机器人才能让世界变得更好;否则,技术进步的成果将导致不平等加剧,甚至可能给全人类带来全球性的严峻挑战。

与其他科技名人相比,教皇的关注重点更为平凡,他更多的是担心这种技术如何加剧此时此地存在的不平等。

已故的英国物理学家斯蒂芬·霍金也曾将人工智能视为对人类未来的最大威胁。

霍金向BBC表示,「开发彻底人工智能可能导致人类灭亡。」霍金的此番警告是回应对他使用的通讯科技的改良,其中就包括了基本的人工智能。

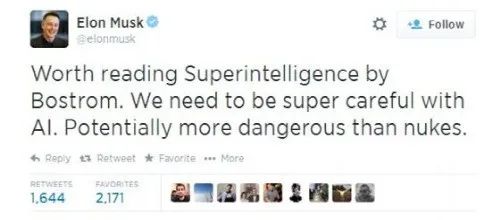

甚至埃隆·马斯克将AI的使用与「召唤魔鬼」进行了比较。

计算机科学家斯图尔特·拉塞尔(Stuart Russell)也在他的著作《人类兼容:人工智能与控制问题》中曾指出,我们应该反思这些警告,即使不以正面结果为代价。

不过,其它科学家并非都对人工智能持如此悲观的看法。

智能机器人(Cleverbot)的发明者罗洛·卡彭特(Rollo Carpenter)表示:「我相信我们还将继续在相当长的时间内掌控科技和它的潜力,并解决世界上的许多问题。」他预示,人工智能将起到正面的作用。

参考链接:

https://www.businessinsider.com/mankind-will-not-be-able-to-control-artificial-intelligence-according-to-study

(声明:本文仅代表作者观点,不代表新浪网立场。)